本文將介紹伴隨新版vSphere 6.0一同釋出的VSAN 6.0,有哪些新增的特色功能機制與原有功能的提升,並且實戰演練VSAN 6.0的儲存資源建立和水平擴充機制,以及示範建立可充分因應機櫃和電力發生故障時的容錯網域機制。

不同的是,在舊版VSAN 1.0內每個VSAN Cluster最多僅支援32 Nodes,而新版VSAN 6.0中可支援至64 Nodes。

另外,在VSAN 1.0版本時期,VSAN Cluster中的每台ESXi主機最多運作100 VMs,而新版的VSAN 6.0可運作最多200 VMs。

同時,舊版的VSAN 1.0雖然檔案系統早就支援62TB儲存空間,但是在VMDK虛擬磁碟方面仍僅支援2TB,到了新版的VSAN 6.0,在VMDK虛擬磁碟部分已經能夠支援至62TB。

值得一提的是,雖然VSAN可與大部分現有的vSphere進階技術如vSphere HA、DRS、vMotion、Storage vMotion等等協同運作。

但是,目前最新版本的VSAN 6.0仍不支援的進階技術包括SIOC(Storage IO Control)、Storage DRS、DPM(Distributed Power Management),這部分管理人員必須特別注意。

實作1:建立VSAN 6.0 Datastore儲存環境

以下分成四個步驟來詳細說明如何建立VSAN 6.0 Datastore儲存環境。

步驟1:設定VSAN專屬網路

雖然VSAN運作架構支援1Gbps及10Gbps網路環境,但根據VMware官方的建議,在VSAN Network專屬網路的規劃上,若採用Hybrid運作架構,則支援採用1Gbps和10Gbps,但如果採用All-Flash運作架構,則僅支援採用10Gbps,以免屆時因為網路環境滿載而造成VSAN運作效能低落。

在虛擬交換器部分,VSAN運作架構支援標準式交換器vSS(vNetwork Standard Switch)及分散式交換器vDS(vNetwork Distributed Switch)。

因此,如果VSAN運作架構規模較小,或許使用vSS虛擬交換器就可以,若是VSAN運作架構規模較大,則建議採用vDS虛擬交換器,除了便於管理及維運之外,還能夠整合只有vDS虛擬交換器才支援的網路流量控制NIOC(Network I/O Control)

功能。

登入vSphere Web Client管理介面後,依序點選「首頁 > 主機和叢集 > ESXi主機 > 管理 > 網路功能 > VMkernel介面卡」項目,然後點選「新增主機網路」圖示。

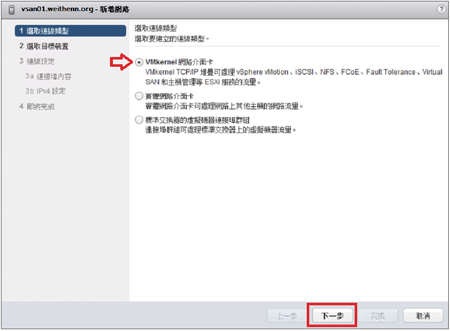

接著,在彈出的新增網路視窗中,到選取連線類型的頁面內點選「VMkernel網路介面卡」項目,以準備新增VSAN網路專屬用途的VMkernel Port,如圖5所示。

|

| ▲圖5 準備新增VSAN網路專屬用途的VMkernel Port。 |

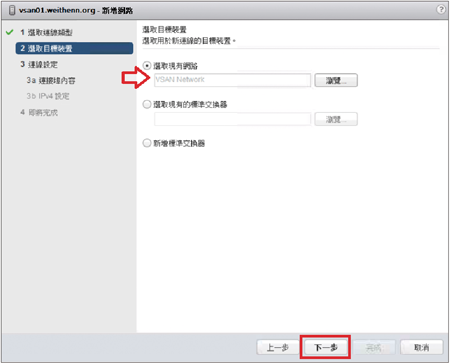

緊接著,在選取目標裝置頁面內點選「選取現有網路」項目,並按下〔瀏覽〕按鈕選擇先前所建立名稱為「VSAN Network」的vDS虛擬交換器連接埠群組,也就是要將VSAN VMkernel Port連接至此Port Group,如圖6所示。

|

| ▲圖6 選擇VSAN VMkernel Port連接至哪個Port Group。 |

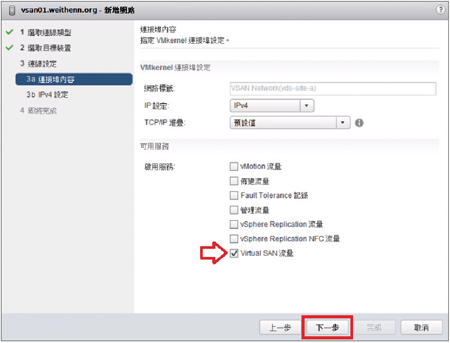

進入連接埠內容頁面後,如圖7所示勾選「Virtual SAN流量」項目,也就是此建立的VMkernel Port將專用於VSAN傳輸流量。

|

| ▲圖7 勾選Virtual SAN流量項目。 |

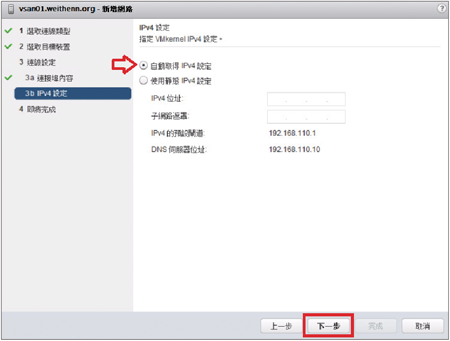

然後來到IPv4設定頁面,設定此VMkernel Port的IP位址即可。此實作環境選擇採用自動取得IPv4位址設定,如圖8所示。

|

| ▲圖8 設定VSAN用途的VMKernel Port IP位址。 |

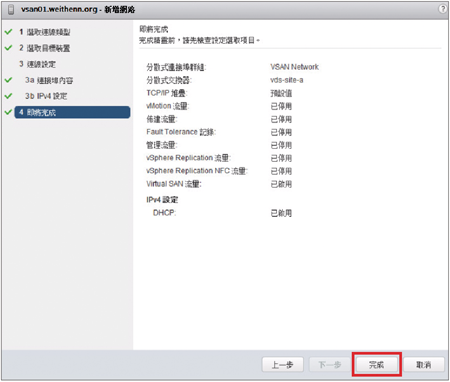

如圖9所示,最後確認相關組態設定內容無誤後按下〔完成〕按鈕即可。

|

| ▲圖9 建立VSAN用途的VMKernel Port。 |