從工作模式到策略決策,隨著人工智慧(AI)快速崛起,尤其是企業對生成式AI應用越益成熟,AI所帶來的風險也讓合規、監管與公司治理等AI治理相關的課題漸漸浮出檯面。根據IBM觀察,由於不少企業對於生成式AI產生內容的穩定度、可信度、透明度、公平性、資訊安全與隱私保護仍有諸多顧慮,目前仍有近一半的企業僅於試行或實驗性質的階段。

其中關鍵點即在於企業的AI治理並未完全落地,根據五月公布的IBM全球CEO調查,高達75%的受訪企業CEO均認為有效的AI治理才能確保AI的可信度,但僅有39%的受訪者表示其企業已落實AI治理。

台灣IBM諮詢首席資料科學家謝明志指出,企業對於生成式AI應用確實有很多期待與想法,然而若想在未來幾年大規模的推展,做好AI治理將會是企業的第一要務。「過去幾年,已經有不少案例突顯出AI治理的重要性。例如2016年發生AI聊天機器人一上線就被網友帶壞,在對話中充滿種族歧視、性別歧視言論而遭下線的案例。2019年高盛在美國發行Apple Card,卻有明明是共用戶頭與財產的夫妻,但妻子能申請到的額度卻不足丈夫的十分之一,因而爆發了Apple Card信用額度的演算機制有性別歧視的嫌疑。」

他提到,不只企業,政府組織也高度關注此一議題,2023年義大利隱私保護監管機構因資安、隱私的各種疑慮而下架ChatGPT,而後在OpenAI解決了相關疑慮後才恢復開放;2024年,歐盟更是在直接在法律層級的EU AI Act畫出紅線,明文禁止在公共場合不能使用生物辨識技術等預測性工具,AI治理的重要性也可見一斑。

三課題落地負責任AI

根據IBM觀點,AI治理指的是能夠協助確保人工智慧系統和工具,符合安全與道德規範的流程、標準以及護欄。有效的人工智慧治理包括監督機制,解決偏見、侵犯隱私和濫用等風險,同時促進創新和建立信任。

謝明志觀察,企業落實AI治理,首要解決的課題就是要有明確的標準作業程序(SOP),才有辦法讓設計好的治理執行框架與規章制度得以真的落地,包含如何判斷公平性、如何驗證其可解釋性,都要有很務實的做法,才有辦法真正把規章制度落實到日常的維運中。

其次要有精確評估的技術手段,舉例而言,如果要從台北開車上高速公路到台中,如果車上沒有時速表與油量表,如何確保上路安全?同理,如果企業大幅度地運用AI,如何知道AI有沒有學壞,有沒有正常地工作,有沒有按照它被賦予的任務去執行,這時就必須要有KPI度量的手段,來獲悉有沒有發生歧視或偏見,可解釋性與可追蹤性有沒有被適當地保持。因此,運用技術手段去監控、評估AI是否有正常的工作,也是落地負責任AI重要的一環。

第三則是要落實自動化,假設企業已部署數十個乃至於上百個AI應用,單靠人力要確認AI每分每秒有沒有正常工作有其難度,這時就須仰賴自動化技術來協助企業更輕鬆地完成,如此才有辦法可以真正地落地到企業的IT、行銷或是數據單位。

AI治理手冊加速規模化應用

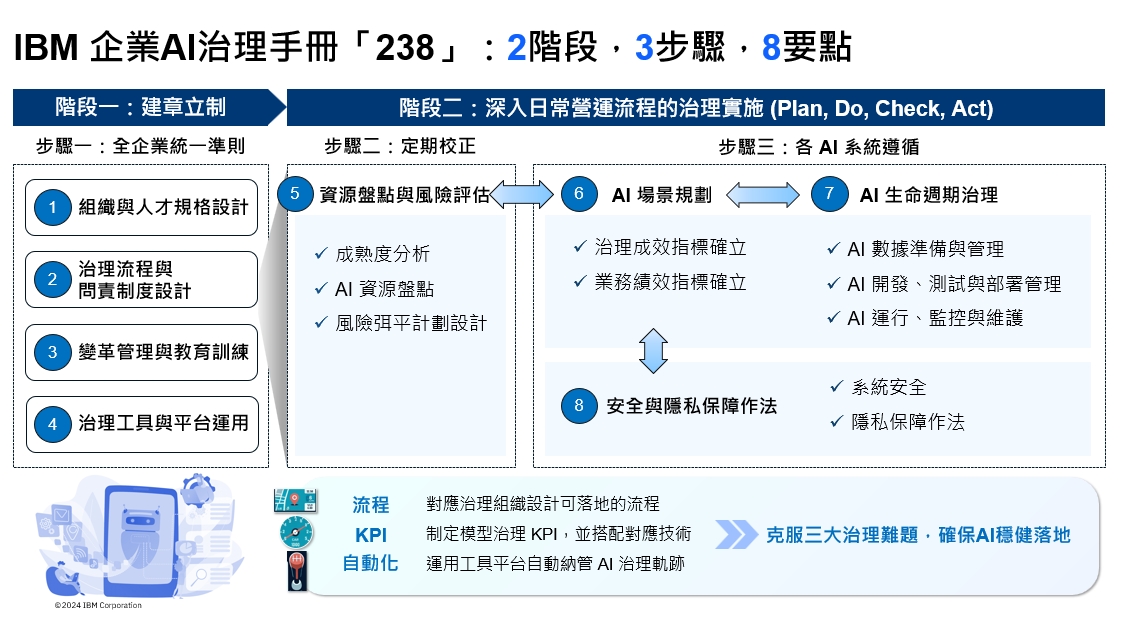

研究AI已經超過60年的歷史,IBM最令人印象深刻的莫過於1997年開發超級電腦「深藍」(Deep Blue)打敗了當時西洋棋的世界冠軍。一路走來,IBM也一直致力於希望AI可以落實到企業,十幾年前就開始研究AI的可解釋性與公平性,也與歐美各國的政府單位充分合作,協助政府組織去奠定AI治理的一些做法、規範、技術的KPI衡量的一些演算法,而這些豐富的經驗,最終也呈現在《AI治理手冊》中。其內容完整涵蓋兩個階段、三個步驟以及八個要點,從策略規劃到執行落地,目的就是協助台灣企業按部就班地進行AI治理,加速實現AI規模化應用。

IBM揭露完整AI治理流程全貌。

IBM揭露完整AI治理流程全貌。

其中,兩個階段分別指的是第一階段的「建章立制」以及第二階段的「深入日常營運流程的治理實施」。前者是從制定AI治理規章制度、建立組織內部流程啟動AI治理,而後者則是透過Plan(計畫)、Do(執行)、Check(檢核)、Action(改善行動)來循環管控。這兩個階段將組成一套端到端、完整的AI治理流程。而在治理落地過程則透過三個步驟與八個要點動態執行。

台灣IBM諮詢數據與科技轉型資深顧問協理林桂如解釋,在建章立制的階段中,企業要採取的步驟就是制定一個全企業統一的準則,往下對應到的執行要點就有組織與人才規格設計、治理流程與問責制度設計、變革管理與教育訓練,以及治理工具與平台的運用等等。而在第二階段,對應的則是步驟二「定期校正」以及步驟三「各AI系統遵循」,其對應到的執行要點則有資源盤點與風險評估、AI場景規劃、AI生命週期治理以及安全與隱私保障作法。

她進一步說明,全球AI治理法規不斷演進,企業內部的AI能力也須與時俱進,因此必須定時反饋,回頭檢查企業本身的成熟度以及企業內部的AI資源盤點,以制定AI治理的風險弭平計劃。進入到步驟三後,就會往下深入到各個AI系統,從資料的產生與注入開始,就嚴加管理,以避免造成AI系統的偏移、歧視或是偏見。此外,針對AI系統業務應用的定位以及技術治理的指標到底要怎麼設定,例如AI系統的公平性與可解釋性要如何計算?目前仍有不少企業不知從何著手,具體來說,須先確立AI應用以及其業務目標為何,其背後連結了哪項技術指標,並且以該項技術指標作為規劃,再往下觀測AI系統整個生命週期,從資料的準備一直到AI開發、模型的測試與部署管理,以及後續的運行、監控與維護。

「當然最重要的部分就是安全跟隱私的保護。各國的AI治理的指導原則都提到安全與隱私保障,」林桂如說明,這就是完整AI治理流程全貌,企業可以將其想像成是GPS導航,用來指引企業到達AI治理的正確的目標。

法規標準跟進 新加坡FEAT原則可借鏡

隨著各國加緊腳步頒布AI治理規範,金管會也在今年六月正式公布「金融業運用人工智慧(AI)指引」,內容涵蓋六大核心原則,包含建立治理及問責機制、重視公平性及以人為本的價值觀、保護隱私及客戶權益、確保系統穩健性與安全性、落實透明性與可解釋性以及促進永續發展等。

不只台灣政府,新加坡金融管理局(MAS)也發展出FEAT原則,即公平性(Fairness)、倫理(Ethics)、問責(Accountability)以及透明性(Transparency),並且於去年帶領Veritas聯盟,發布開源工具包Veritas Toolkit 2.0,以協助金融機構負責任地應用AI。

「為了回應企業和社會對AI技術規範和指引日益增長的需求,全球第一個人工智慧(AI)管理系統國際標準ISO/IEC 42001也在去年發布,著重的重點類似企業的AI體質健檢,根據各種不同的面向,包含組織流程等等,協助企業判斷風險落差。」她提到,在亞洲國家中,新加坡在AI治理的進展其實最快,其所設計的原則重點更為落地,除了要求收集AI應用系統數據外,也會將其落實在企業的組織跟流程的問責機制,當系統發生問題時,便可以透過框架跟機制,快速地釐清是資料工程師應該負責,還是資料科學家應該要對模型負責。

三階段助力啟動 合規也要效益回收

林桂如強調,IBM所發布的AI治理手冊其實就涵蓋了上述法規要求與框架重點,而且會分三階段來協助企業啟動AI治理,針對基礎的合規,IBM會先花費6到9個月的時間協助企業先盤點AI系統,並且針對企業內部的AI系統做風險分級。再依據AI系統與數據協助企業設計組織流程,以及未來落地執行問責的制度,並且依據風險落差來補強。

第二階段則是協助企業改善體質,針對不同風險與技術的AI應用,依風險落差制定改善作法,並且加以實施,包含系統、數據來源以及流程跟組織均須加以改善,在這個階段大約需要再花三個月的時間來落實分級落地管控。

最後是規模化全企業實施,「導入AI或生成式AI並不只期望合規而已,企業投入大量資源與預算,採購AI設備、打造AI腦,還是會期望能夠有成本效益的回收。」她提到,IBM也希望協助企業未來能夠大規模實施可落地的AI治理,讓這些AI系統跟平台能夠商業化大規模部署跟應用。此時就需要運用到自動化治理的機制跟平台,才能夠因應大規模的AI部署。「其實有不少企業目前的AI運行模型已經多達八、九十個,如果資料的收集都用人工或Excel的方式,根本就沒有辦法做到完善的治理。因此,在大規模部署的階段,自動化的一個平台跟技術就很重要。」

金融以機制監督 打造更好的互動體驗

毫無疑問,人工智慧、生成式AI技術已然改變了產業的運作方式以及與客戶互動的模式。而這其中,金融產業面臨的挑戰更甚,由於業務需要,金融單位往往需要收集消費者諸多的個資或隱私資料,再加上法規遵循的壓力,也使得金融產業不得不開始正視AI治理。

台灣IBM諮詢數據與科技轉型資深顧問協理林桂如指出,在亞洲國家中,新加坡在AI治理的進展最快。

台灣IBM諮詢數據與科技轉型資深顧問協理林桂如指出,在亞洲國家中,新加坡在AI治理的進展最快。

謝明志指出,不少金融產業為了提供給顧客更好的服務體驗,紛紛運用AI或生成式AI來打造互動式體驗,不管採用的大型語言模型是來自於雲端或自建於企業內部,治理的目的就是在營運的過程中,讓企業能掌握到這些互動的細節,例如有沒有帶歧視、偏見或是不當言語,如此才能有辦法得知該項功能是否有按照規劃與期望運作。

而落到實務上的作為,首先就必須要有一套機制、系統,定期地自動化把這些資料收集下來,同時運用多個專案型AI,各自負責偵測不當言論、歧視或是個資隱私,簡單地說,就是會有一個監督的AI治理的方法/模組,專門針對任務去監控個互動過程,將會一個比較恰當的做法。

至於,涉及到隱私或是不當言論是否要在回覆給客戶前就應該要被發現,則取決於風險評估,他提到,完善的AI治理也應該把細節納入考量,如果是與消費者有關的線上服務,甚至會談到銷售或貸款內容時,就必須以高規格來看待,在回覆消費者之前,所有回覆的內容都需要經過檢測,才能與消費者互動。但如果是員工的訂便當系統,由AI來建議今天可以吃哪家便當,像這類的應用本身敏感度就不高,因此就不需要花費高規格的資源進行處理。這也是為何AI治理框架也需要風險分析,不同的風險等級需要有不同的規劃設計以及資安防護措施才能確保AI穩固運行。