面對機架密度、功耗以及發熱量快速上升,在既有的資料中心內添加液冷散熱方案,已成為企業不得不的考量。根據Vertiv公布的《在資料中心部署液冷-高密度冷卻指南Deploying liquid cooling in the data center-A guide to high-density cooling》,近五分之一的資料中心(17%)已經使用液體冷卻,另外有61%的營運團隊正考慮在其設施中使用液體冷卻。

Vertiv很早便觀察到液冷需求與趨勢,2022年發布首款專為高密度資料中心設計的Liebert VIC浸沒式液冷創新解決方案(Liquid Immersion Cooling Solution)。這款單相浸沒式冷卻方案,可支援功率密度高達200kW的機櫃,其使用ElectroSafe電介質液體冷卻劑,可讓伺服器直接浸沒在冷卻液中散熱,因此無須安裝風扇,可節省10%至20%的IT設備耗能,整體PUE值可達1.05。

另外,也結合了Vertiv Liebert PCW氣態冷卻方案與Vertiv Liebert XDU液體冷卻方案,打造出單櫃熱負載達80kW以上的混合式冷卻系統。今年稍早,Vertiv也公布了與NVIDIA一同針對高密度資料中心製冷方案進行研發測試的實測數據,發現IT負載從100%風冷轉為75%液冷的方案時,伺服器風扇用電量降低最多達到80%,使整體使用效率(Total Usage Effectiveness,TUE)提高15%以上。

Vertiv技術顧問暨市場行銷專員王仁佑指出,早在AI元年尚未來到之前,約莫是五年前,Vertiv便與業者密切合作提供解熱方案,在當時Vertiv便已察覺到氣冷不足以帶走晶片產生的廢熱,而必須改採水冷的方式,才能達到散熱的效果。這項試驗是以常見的中型1,000kW至2,000kW資料中心進行分析,其包含50個高密度機櫃,除了原有的風冷裝置Vertiv Liebert PCW外,液冷系統由Vertiv Liebert AFC冷水機組,以及兩個配備液體對液體熱交換器的Vertiv Liebert XDU冷卻液體分配單元組成。

機櫃密度攀升 散熱從氣冷過渡液冷

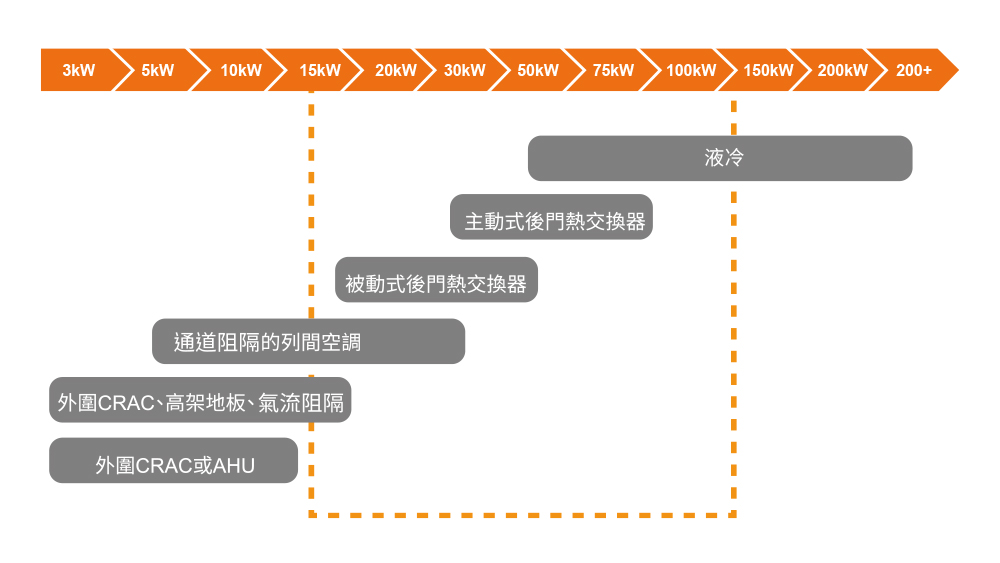

傳統以來,氣冷均是藉由靠近熱源(如列間空調)或是密閉冷通道/熱通道來克服更高密度的散熱需求,但隨著機櫃密度攀升到20kW以上,氣冷的散熱效果逐漸降低,而這也促使散熱技術從氣冷過渡到液冷,目前市場上也推出了多款散熱解決方案,包含後門熱交換器(Rear Door Heat Exchanger,RDHx)、Side Car或是浸沒式冷卻(Immersion Cooling)。

當機櫃密度超過20kW時,氣冷散熱成效會逐漸減少,此時便可搭配液冷散熱方法。(資料來源:Vertiv 網管人重製)

當機櫃密度超過20kW時,氣冷散熱成效會逐漸減少,此時便可搭配液冷散熱方法。(資料來源:Vertiv 網管人重製)

他提到,後門熱交換器的原理是透過安裝在伺服器機櫃背面的熱交換器來帶走IT設備的熱,其包含了盤管與風機,冷卻水會在盤管內流動,而風機會將空氣中的熱吸入盤管,以便帶走熱量。目前可以支援到50kW的機櫃功率密度。「這種液冷與氣冷協同作業模式已經是氣冷伺服器解熱的天花板了,如果機櫃的功率密度更高,常見的作法是液冷伺服器會搭配Side Car來提高解熱的能力。」

而Side Car則有兩種形式,一種是液態對液態,另一種是液態對氣態。如果是液態對液態,其設計概念與冷卻液分配裝置(CDU)類似,它需要與冰水主機相連,冰水主機的水要進到CDU(一次側),然後與CDU的二次側(液冷機櫃)進行熱交換。而液態對氣態的一次側則是資料中心空間的風流,因此,會對環境的溫度有所要求。他提到,但是液態對氣態的Side Car,建置的速度最為快速,資料中心並不需要特別改動,只要把Side Car接上AI伺服器的快接頭即可,不過由於最終是透過整個資料中心空間的溫度來把熱帶走,因此對資料中心的溫度還是會有些要求,一般可解熱到70至100kW。

「至於浸沒式冷卻的原理,是把伺服器以及機櫃中的其他元件浸泡在導熱的絶緣液體或是流體中,藉由這種方法無須氣冷散熱,伺服器也不需要風扇讓空氣流動散熱,因此能有最好的節能效益。儘管如此,現階段仍需要長時間的測試,雖然可以透過技術來模擬環境以加快老化測試或是腐蝕測試等等,不再需要經過幾十年,但至少也要再幾年才會採用。」王仁佑說。

為AI伺服器額外擴充改造

隨著越來越多企業將人工智慧和機器學習應用於各個領域,AI正在重塑產業並且改變其營運方式,包含醫療保健、金融、製造、交通以及零售等領域,AI應用可謂遍地開花。而這當然有賴於機器學習、自然語言處理和電腦視覺的進步,以及大型語言模型(LLM)等技術發展。根據Grand View Research調查,到了2028年,全球人工智慧市場規模預計將達到7,337億美元,2021年至2028年的年複合增長率為42.2%。

Vertiv技術顧問暨市場行銷專員王仁佑認為,若企業算購置一櫃至兩櫃的AI伺服器,或是在資料中心中留一小區域專門放置AI伺服器,這時候資料中心的改造才會有意義。

Vertiv技術顧問暨市場行銷專員王仁佑認為,若企業算購置一櫃至兩櫃的AI伺服器,或是在資料中心中留一小區域專門放置AI伺服器,這時候資料中心的改造才會有意義。

不過,企業在部署AI伺服器以支援AI創新應用的同時,資料中心的設計與規劃也會因此而受到牽動。他提到,早期單一機櫃只需3kW或5kW,即使是雲端服務供應商這類型的大型企業,單一機櫃也差不多落在10kW到19kW的區間,但如今,Vertiv單櫃功率密度最高已來到136kW。這個差距意謂著伺服器的熱密度已上升了五倍以上,換言之,企業需要五倍以上的電力。而在給予五倍電力的同時,也會產生五倍以上的熱需要解決。

電力的問題較為單純,就是向台電申請擴增電力,而後再找設備商採購可產生相對應規格的電力設備,而冷卻能力不足,就需要搭配液冷散熱方案來克服,但企業還會面臨一項挑戰即是載重問題。他提到,就算只是運用後門熱交換器,樓地板的承重也會增加,若是既有資料中心的高架地板原本載重就不高,那麼單一機櫃可放置的AI伺服器數量就會有限。

「事實上,企業如果只是打算採購一台至兩台AI伺服器,那麼資料中心會遭遇到的問題並不大,只要分散部署,可能連電力都可以不用額外申請。但倘若企業打算購置一櫃至兩櫃的AI伺服器,或是在資料中心中留一小區域專門放置AI伺服器,這時候資料中心的改造才會有意義。」他提到,目前接觸到的企業作法,會比較像是在資料中心旁找一區域設計成小型的AI資料中心。機櫃數大約兩櫃至三櫃,甚或是五櫃左右,只要向台電申請額外電力,而後就可以開始規劃低壓配電盤、不斷電系統等等,以及要不要備援機制等等,而散熱方面就是搭配液冷方案進行設計。 王仁佑強調,就算企業部署了高階的液冷伺服器,機櫃內還是會有交換器等其他設備,需要用氣冷的方式來散熱,因此現階段的AI資料中心,還是會走向液冷與氣冷混合運用的Hybrid設計。