企業在導入虛擬化平台之前,應先分析該採購那些規格的實體伺服器來符合自身的營運需求,並了解Hypervisor的運作特性與方式,以及運作後如何優化調校VM虛擬主機當中的Guest OS。

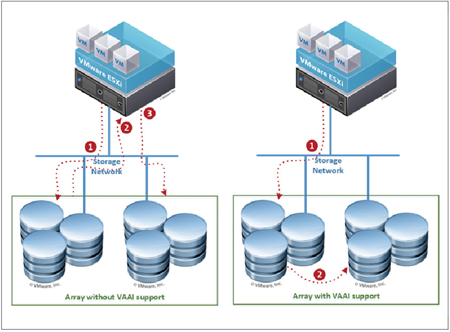

Scalable Lock Management(或稱Atomic Test and Set,ATS)機制,能夠有效減少Locking-Related工作負載的開銷,並且在處理File System-Intensive工作負載時,仍能有效提高Thin Disk的磁碟空間擴展速度。

而UNMAP機制可使Thin Disk自動完成空間回收(Reclaim Space)的任務,而不需要如傳統解決方案利用SDelete指令或Storage vMotion來釋放空間(因為Space-Efficient Sparse Virtual Disks機制目前僅針對VDI VM作用)。

|

| ▲圖6 VAAI – Full Copy運作示意圖。(圖片來源:TechRepublic網站 - VAAI should be a requirement in your next storage array) |

週邊匯流排及介面卡(Peripheral Bus & Adapter)

在介面卡方面,請採用通過VMware Hardware Certification驗證流程的介面卡,同時為了避免傳輸瓶頸卡在匯流排上,建議採用速度較快的「快速週邊組件互連(PCI Express,Peripheral Component Interconnect Express)」,目前主流規格為PCIe 3.0 x8或x16。

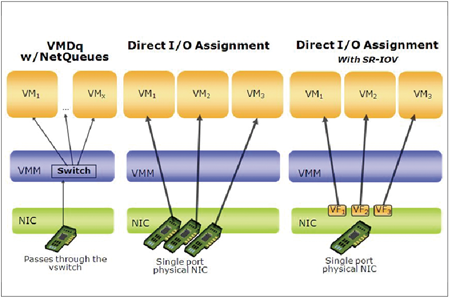

在挑選網路介面卡時,則盡量選擇可減緩ESXi主機CPU工作負載的介面卡,例如支援NetQueue(圖7)、Checksum Offload、TSO(TCP Segmentation Offload)、LRO(Large Receive Offload)等等卸載功能。

|

| ▲圖7 NetQueue運作示意圖。(圖片來源:Intel網站 – I/O Virtualization) |

若採用Fibre Channel的SAN架構,可以調整Queue Depth數值以加速Fibre Channel HBA Card傳輸效能。例如,若在vSphere ESXi 5.5虛擬化平台中採用QLogic HBA Card,可將Queue Depth數值調整為「64」(詳請參考VMware KB 1267)。但必須注意的是,如果安裝的FC HBA卡是採用End-to-End架構(HBA卡直接),則必須避免傳輸速度不一致的情況,否則很容易發生傳輸效能不彰的情況(詳請參考VMware KB 1006602)。

此外,介面卡該選擇單埠(Single Port)、2埠(Dual Port)或者是4埠(Quad Port)?若實體伺服器的PCIe Slot足夠,建議採用單埠(Single Port)的介面卡比較適合,主因是為了避免傳輸瓶頸卡在PCIe Slot匯流排。

因為目前主流的PCIe 3.0 x16在全雙工的情況下傳輸也只有8Gb/s(下一代的PCIe 4.0 x16則能達到16Gbps),但若在該PCIe Slot中插上2埠10G網路卡,可想而知,當工作負載接近滿載時,勢必會造成傳輸瓶頸卡在PCIe Slot匯流排的現象。

除了伺服器的匯流排需要注意外,「傳輸線材」的部分也值得注意。目前10Gbps網路環境正逐漸普及當中,但以往乙太網路環境內的Cat 5、Cat 5e已經無法使用,至少應採用Cat 6a或Cat 7等級的纜線,才能達成在10Gbase-T網路環境中100公尺的最大理論傳輸距離(採用Cat 6,則有55公尺的最大理論傳輸距離)。

BIOS/UEFI設定

雖然在實體伺服器CPU處理器方面,已經選購了支援硬體輔助虛擬化技術,但其實主機板的BIOS/UEFI也必須進行啟用(Enabled)才行。

首先,在前述介紹中第一、二代硬體輔助虛擬化技術,在BIOS當中並不會看到相同技術名詞。以採用Intel CPU處理器的伺服器來說,只會在BIOS當中看到「Virtualization Technology」項目,請確保該項目為啟用狀態。若想讓ESXi虛擬化平台保持在高效率的運作環境上,則將BIOS內的Intel Turbo Boost或AMD Turbo CORE項目也進行啟用。

至於HT(Hyper-Threading)項目,則視運作環境需求,自行決定是否啟用或停用,因為HT機制雖然會將目前的核心數量提升一倍,但因為並非真正的運算核心(僅邏輯運作),所以當多線程的應用程式要進行SMP平行運算時,可能會反效果讓運作效能更差。

C1E機制雖然可以在不影響效能的情況下降低電力的使用,且當Intel Turbo Boost或AMD Turbo CORE也啟用時,對於Single-Threaded Workloads有提升的效果,但對於Highly Sensitive I/O Latency工作負載而言則會嚴重降低效能,所以也必須視運作環境來決定是否啟用或停用。

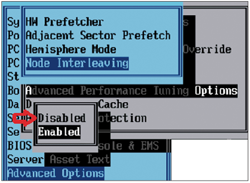

先前提到的NUMA機制,除了實體記憶體應該平均分配之外,在BIOS中的設定名稱為「Node Interleaving」,這個項目必須設定為禁用(Disable)才是「啟用NUMA」機制,該項目若設定為啟用(Enabled),反而會禁用NUMA機制,如圖8所示。

|

| ▲圖8 將Node Interleaving設定為Disabled以啟用NUMA機制。 |

在BIOS的電力設定方面,建議設定為最佳效能(Maximum Performance),或者設定為「OS Controlled Mode」,也就是把電力控制權交給屆時的ESXi虛擬化平台。最後,將用不到的週邊裝置直接在BIOS層級就進行停用,例如COM/LPT Ports、Floppy/CD/DVD Drives、USB Controllers/USB Network Interfaces等。

ESXi主機效能調校

VMware vSphere ESXi為Type 1 Hypervisor運作架構,安裝完畢,便能在ESXi虛擬化平台上同時運作多台VM虛擬主機,並且有效率地共享如中央處理器(CPU)、記憶體(Memory)、磁碟I/O(Disk

I/O)等等的底層硬體資源。

電力配置優化

企業或組織導入虛擬化平台,除了將實體伺服器進行整併外,另一個關鍵因素是,當時間拉長來看時,整個機房的電力節省、不同的實體伺服器和相關週邊配件,也會導致不同的電力損耗。

舉例而言,中央處理器一般都會有所謂散熱設計功率(Thermal Design Power,TDP)評等,應盡量挑選TDP數值較低的CPU處理器,在記憶體方面也會因為如錯誤檢查和糾正(Error Checking and Correcting,ECC)等相關技術,而影響電力損耗大小。另外,實體伺服器採用的硬碟種類及轉速、網路卡、風扇等等,也將影響整體的電力損耗數值。