隨著AI的快速發展,其可能造成的威脅與風險,也引起大家廣泛的討論與關注,歐盟於2021年4月提出《人工智慧法》草案,採取風險管理導向的方法來對AI進行規範,經過多次討論與修改,該法已於2024年3月13日經歐洲議會通過,這是全球第一個全面規範AI的法律架構。

由Google公司所開發的AlphaGo於2016年3月擊敗世界頂尖圍棋手李世乭後,開啟了人工智慧(AI)的另一波狂潮,而Open AI於2022年12月發表聊天機器人模型Chat GPT,更將AI的發展帶到另一個里程碑。

然而,隨著AI的快速發展,其可能造成的威脅與風險,也引起大家廣泛的討論與關注,為管理AI可能產生的風險,歐盟於2021年4月提出《人工智慧法(Artificial Intelligence Act)》草案,採取風險管理導向的方法來對AI進行規範,經過多次討論與修改,該法已於2024年3月13日經歐洲議會通過,這是全球第一個全面規範AI的法律架構。以下係對這部法律做簡要的介紹:

適用對象

歐盟人工智慧法的適用對象不只是設立於歐盟境內的AI系統供應商及部署者,任何將AI系統、通用AI模型投放到歐盟市場或投入服務的供應商,不論其是否設置於歐盟境內也要適用該法律。另外,設置於歐盟境外,但系統輸出結果會在歐盟使用的AI系統供應商或部署者,也需適用這部法律。

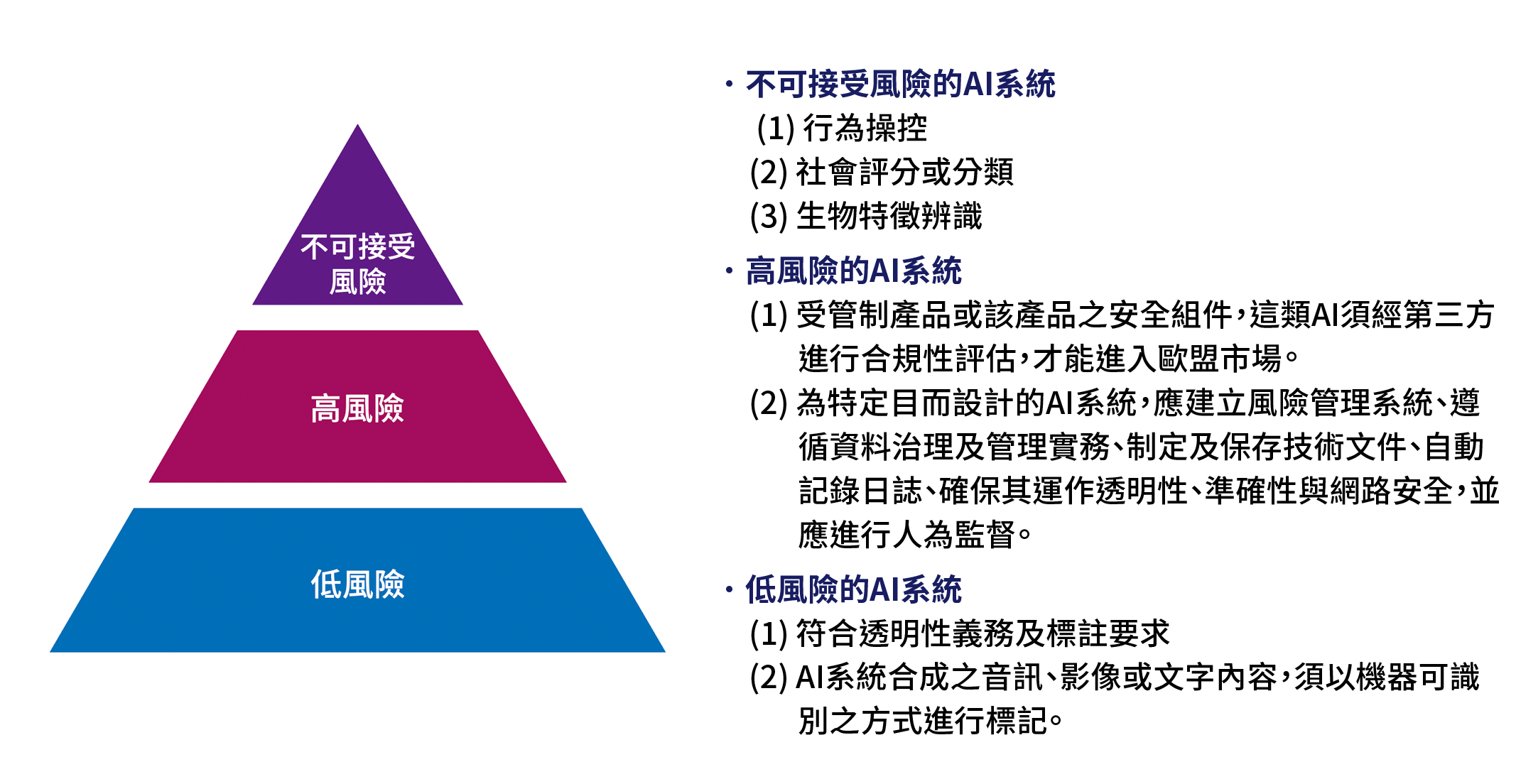

歐盟人工智慧法是依造AI系統對歐盟基本價值或基本權利所產生的風險高低,區分成不可接受之風險、高風險及低風險AI系統等三種類型。(網管人整理製作)

歐盟人工智慧法是依造AI系統對歐盟基本價值或基本權利所產生的風險高低,區分成不可接受之風險、高風險及低風險AI系統等三種類型。(網管人整理製作)

風險分級與管理

歐盟人工智慧法是依造AI系統對歐盟基本價值或基本權利所產生的風險高低,區分成不可接受之風險、高風險及低風險AI系統等三種類型。

不可接受風險的AI系統

這類型的AI系統,因違反歐盟基本價值,應明文禁止其發展,其包括:

(1)行為操控:利用潛意識技術或故意操縱、欺騙之技術,或利用特定群體之脆弱性(年齡、身心障礙等),扭曲其行為,造成該人或他人身心之傷害。

(2)社會評分或分類:根據社會行為或已知、推斷、預測的個人特徵,對人進行評估或分類,而對其產生不利結果;根據資料分析及人格特質評斷,評估或預測其實施刑事犯罪的風險;在工作場所和教育機構,進行情緒識別(除非基於安全和醫療之原因);根據生物辨識資料對人進行分類,以推斷其種族、政治觀點、工會成員身分、宗教或哲學信念、性生活或性取向(不包括對合法取得的生物辨識資料進行標記或過濾)。

《人工智慧法案》是歐洲針對人工智慧(AI)制定的一項法規。

《人工智慧法案》是歐洲針對人工智慧(AI)制定的一項法規。

(3)生物特徵辨識:透過從網路或閉路電視錄影,無針對性地抓取臉部影像,以建立人臉辨識資料庫;基於執法目的,在公共場所進行即時遠端生物特徵辨識(除非符合特定例外規定)。

高風險的AI系統

這類型的AI系統,因會對自然人的健康、安全和基本權利造成損害,故原則上雖可進入歐盟市場,但須符合歐盟特定的法律要求。其包括:

(1)附表1(https://artificialintelligenceact.eu/annex/1/)歐盟調和立法清單(List of Union Harmonisation Legislation)所列之管制產品或該產品之安全組件,這類AI須經第三方進行合規性評估,才能進入歐盟市場。

(2)附表3(https://artificialintelligenceact.eu/annex/3/)所列之為特定目的而設計的AI系統,包括:歐盟或國家法律允許使用之生物辨識技術、關鍵基礎設施管理與營運之安全組件、教育及職業訓練相關系統(評估學習成果、監測違禁行為)、雇用及人員管理(人員招募或甄選、分配任務、評估績效)、獲得及享受基本私人及公共服務(基本公共援助福利資格之評估、信用評分、保險的風險評估和定價、緊急呼叫的評估和分類)、執法、移民及邊境管理、司法與民主程序。這類高風險AI系統的提供者,應建立風險管理系統、遵循資料治理及管理實務、制定及保存技術文件、自動記錄日誌、確保其運作透明性、準確性與網路安全,並應進行人為監督。

低風險的AI系統

為避免冒充及詐騙之風險,須符合透明性義務及標註要求,例如AI系統直接與自然人進行互動時,系統提供者應使相關自然人知悉他們正在與AI系統互動,而AI系統合成之音訊、影像或文字內容,須以機器可識別之方式進行標記,情緒或生物辨識系統的部署者,應使接觸該系統的自然人知悉系統運作之情形。

對通用AI模型之規範

Chat GPT在2022年底出現後,旋即引發風潮,但也隨之產生大量個資、隱私及智慧財產權之爭議,歐洲議會因此於2023年5月11日決議將通用AI模型之規範加入歐盟人工智慧法中。

通用AI模型之規範,係要求通用AI模型的提供者,應遵守透明性義務,而須(1)制定及保留該模型之技術文件,以便於必要時提供給AI辦公室和主管機關查核;(2)制定及保留資訊及文件,以提供給欲整合該模型之AI系統提供者;以及(3)根據AI辦公室提供的範本,制定及公開通用AI模型的訓練資料。此外,亦要求該提供者應制定政策以遵守歐盟著作權法及其相關法律規定。

另外,具系統性風險之通用AI模型提供者,(1)應依標準化協定及工具進行模型評估,包括進行模型對抗性測試,以識別及降低系統風險;(2)應追蹤、記錄並向AI辦公室進行報告,嚴重事件的相關資訊及可能採取之改善措施;(3)應對該模型及其基礎設施,提供足夠的網路安全保護。

支持創新之措施

歐盟人工智慧法為鼓勵創新,特別要求其成員國應在國家層級建立至少一個AI監管沙箱,提供受控制的環境,以促進創新,並在有限的時間內,協助創新AI系統的開發、培訓、測試和驗證。

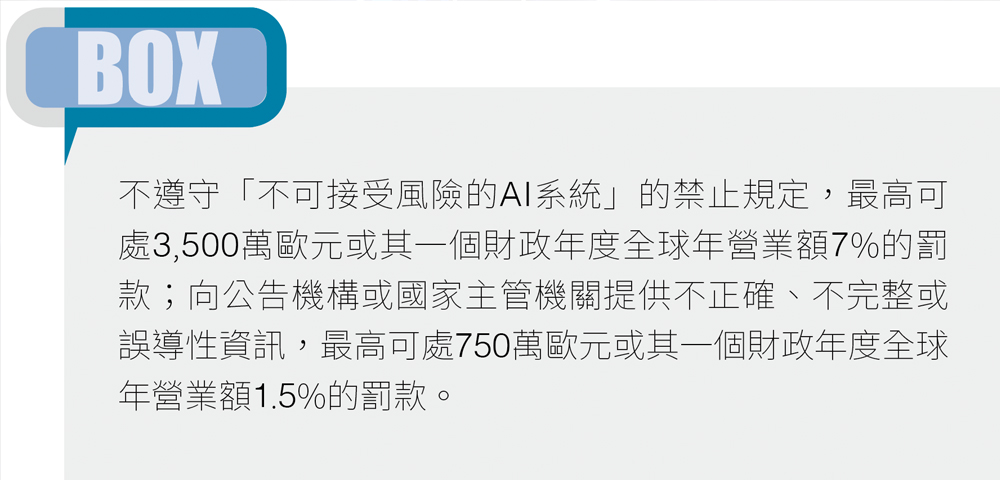

相關罰則

不遵守「不可接受風險的AI系統」的禁止規定,最高可處3,500萬歐元或其一個財政年度全球年營業額7%的罰款,而不遵守前述規定以外的規範義務,最高可處1,500萬歐元或其一個財政年度全球年營業額3%的罰款。

另外,向公告機構或國家主管機關提供不正確、不完整或誤導性資訊,最高可處750萬歐元或其一個財政年度全球年營業額1.5%的罰款。前述處罰,一般企業以較高者為準,但新創企業以較低者為準。

結語

歐盟人工智慧法於2024年3月13日通過後,大部分的規定預計於2026年第2季以後生效。對此,台灣的AI系統或服務提供者應先盤點其所提供之AI系統或服務是否有投入歐盟市場,是否須適用該部法律,而需適用該法律,則應評估其系統之風險層級及應遵守之相關規範,再依規定淘汰禁止使用的系統,並對其他非禁止使用的系統,依該法律之規定,完善相關程序,制定、修改、提供相關文件,並建立相關安全措施,以符合該法律之要求。

<本文作者:黃于珊,目前為執業律師。輔仁大學圖書資訊與資訊管理雙學士,交通大學科技法律研究所碩士,美國華盛頓大學智慧財產權法碩士,曾擔任系統工程師、專利工程師。專攻領域為智慧財產權法、個人資料保護法、高科技產業議題及資訊通訊法等。>