挺過疫情低潮,今年台北國際電腦展(COMPUTEX 2024)恢復往年盛況甚有過之,不只主題演講人潮滿滿,最後一日也湧進大量民眾入場。根據官方資料,四天展期間共吸引8萬5千多位專業人士進場參觀。

人工智慧已成為全球加速運算發展的主要驅動力之一,今年台北國際電腦展的主軸也環繞著AI科技為核心,從雲端、核心、邊緣乃至於PC,各家大廠無不卯足全力佈局,看重的即是由硬體創新所帶動的AI應用,鑑於台灣完整的ICT生態體系,晶片業者也紛紛在此時發表新的晶片設計,包含超微(AMD)、英特爾(Intel)以及輝達(NVIDIA)都有新品發布。

不只是CPU與GPU,晶片之戰也延燒到NPU,AI PC儼然成為另一戰局,針對微軟「Copilot+PC」40 TOPS以上的要求,Intel與AMD也相繼推出因應方案。而在企業伺服器領域,GPU的較勁仍是重頭戲,Intel Gaudi AI加速器來勢洶洶,AMD也有Instinct MI325X加速器應戰。

從企業應用的角度來看,生成式AI的應用不只要算力到位,軟體也是非常重要的關鍵,NVIDIA NIM微服務就是一項值得觀察的指標,隨著越來越多的模型與推論運行在微服務架構,勢必也會成為企業加速擁抱微服務的一股驅動力。

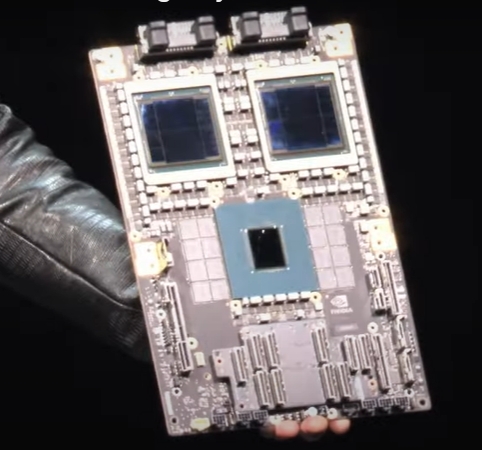

NVIDIA執行長黃仁勳展示結合「Grace」CPU與兩組「Blackwell」GPU的GB200結合於單一節點的超級晶片。

NVIDIA執行長黃仁勳展示結合「Grace」CPU與兩組「Blackwell」GPU的GB200結合於單一節點的超級晶片。

克服算力通膨挑戰 推論微服務輕鬆建構Gen AI

選在Computex展會前夕於台大綜合體育館發布主題演講,NVIDIA執行長黃仁勳直言,支撐整個電腦產業引擎的處理器,其效能擴展的速度正在減緩,但在此同時,需要處理的資料量卻以極快的速度呈指數型增長,如果需要處理的資料量持續激增,但是運算的效能沒有跟上,那麼就會面臨算力通膨(Computation Inflation)的挑戰。他認為,加速運算(Accelerated Computing)技術正是解方,在不久的將來,每一種運算密集型的應用都將採用加速運算技術,而且每一個資料中心也必定如此。只需要增加3倍的功率以及50%的採購成本,資料中心就能取得100倍效能提升的好處,這意謂著造價10億美元的資料中心,透過添加5億美元的GPU,就能搖身一變成為AI工廠。

隨著生成式AI崛起,資料生成增長,算力需求也會與之攀升,黃仁勳在演講中也特別展示了結合「Grace」CPU與兩組「Blackwell」GPU的GB200於單一節點的Superchip,透過每秒10TB(TB/秒)的晶片對晶片互連技術將兩組Blackwell GPU連接在一起,同時還搭載了可靠性、可用性和可維護性(RAS)引擎,可增加智慧復原能力,及早辨認出可能發生的潛在故障,盡可能縮短停機時間。他提到,Blackwell還配備解壓縮引擎,能夠以比現在快20倍的速度從儲存中提取資料,若是使用Blackwell來訓練具有兩兆參數的大型語言模型GPT-4系統,所需要消耗的電力,僅僅需要原來的1/350。

針對液冷散熱設計需求,NVIDIA也推出全新模組化參考設計的MGX系統,可針對不同的工作負載而有不同配置。同時,黃仁勳也預告,將於2025年推出Blackwell Ultra晶片,以及2026年推出新一代平台Rubin。

不只是在GPU晶片技術演進,在為時2小時的演講中,他也提到了NVIDIA Spectrum -X乙太網路平台,以及以最佳化容器形式提供模型的推論微服務NVIDIA NIM。其中,Spectrum-X配備NVIDIA Spectrum SN5600乙太網路交換器和NVIDIA BlueField-3 SuperNIC,可為人工智慧、機器學習、自然語言處理以及各種產業應用程式提供最佳效能,與傳統乙太網路結構相比,生成式AI網路效能提高了1.6倍。Spectrum-X800可大幅提高網路效能,總頻寬可達51.2Tbps;而NVIDIA NIM則能讓使用者透過標準化的方式,簡單將生成式AI加入應用程式,顯著提高開發人員的工作效率。開發人員只需要在數分鐘內就能輕鬆構建用於輔助夥伴(Copilot)、聊天機器人等的生成式人工智慧應用程式,而這個過程原先需要耗費數週的時間。

從資料中心到PC AMD打造端到端AI基礎架構

擔任Computex開幕主題演講,AMD董事長暨執行長蘇姿丰在一開始便強調,AI是AMD的首要任務,並將專注於三個優先事項,首先是用於AI訓練與推動的高效節能運算引擎,包含CPU、GPU以及NPU。其次是開放、經過驗證且友好的生態系,能夠確保所有領先的AI框架函式庫與模型,能夠在AMD的硬體啟用。第三則是與合作夥伴共同創新,致力與全球的雲端、OEM、軟體和AI公司合作,並且為世界帶來最好的人工智慧解決方案。

從雲端、企業資料中心到5G網路、醫療保健、工業、PC、遊戲與AI,AMD科技已無所不在,在開幕主題演講中,蘇姿丰也揭示領先業界的全新CPU、NPU以及GPU架構,打造從資料中心到PC的端到端AI基礎架構,並且揭曉AMD Instinct加速器藍圖,發布全新的AMD Instinct MI325X加速器。此外,也預覽具有領先效能與效率的第5代AMD EPYC伺服器處理器,以及全球最快的消費級桌上型處理器AMD Ryzen 9 9950X。

AI已經徹底改變了人們與PC互動的方式,想要加速內容創作的能力或是希望有個客製化的數位助理可以幫助進行決策,以及決定下一步該做什麼,就需要更好的AI硬體。對此,AMD也發布第3代AMD Ryzen AI處理器,這款專為超薄與高階筆記型電腦設計的下世代處理器,結合了Zen 5架構的CPU、RDNA 3.5繪圖卡以及XDNA 2 NPU,「AMD把最好的技術都集中在一個晶片上,」她提到,全新的NPU可提供50 TOPS的AI處理能力,超越Copilot+ AI PC要求,而且也是唯一支援先進Block FP16資料類型的NPU,精準度超越競爭對手且不會犧牲效能;而新款處理器採用全新的Zen 5架構,其配備多達12個高效能CPU核心可運行24個執行緒,讓超薄筆記型電腦可擁有高階的運算效能。

而在邊緣AI方面,全新第2代AMD Versal AI Edge系列為邊緣AI提供最高效能的單晶片自行調適解決方案。其結合FPGA的可程式化邏輯以執行即時的預先處理、基於XDNA技術的新一代AI引擎執行高效的AI推論以及嵌入式CPU執行後處理,目前已經有超過30家的重要合作夥伴正著手開發相關產品。

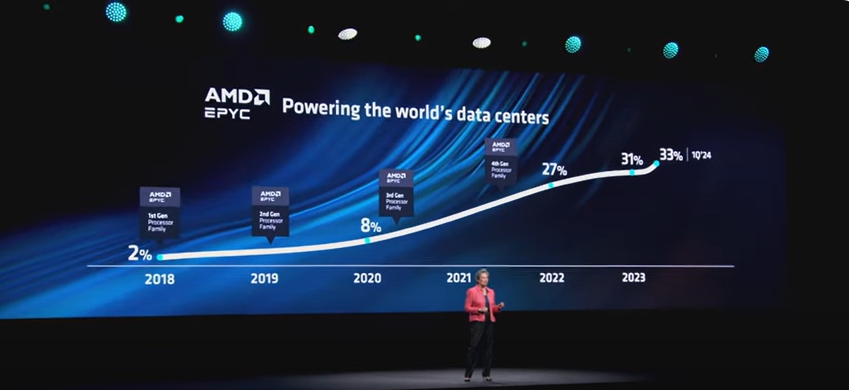

AMD董事長暨執行長蘇姿丰指出,AMD在伺服器CPU市場佔有率已到33%。

AMD董事長暨執行長蘇姿丰指出,AMD在伺服器CPU市場佔有率已到33%。

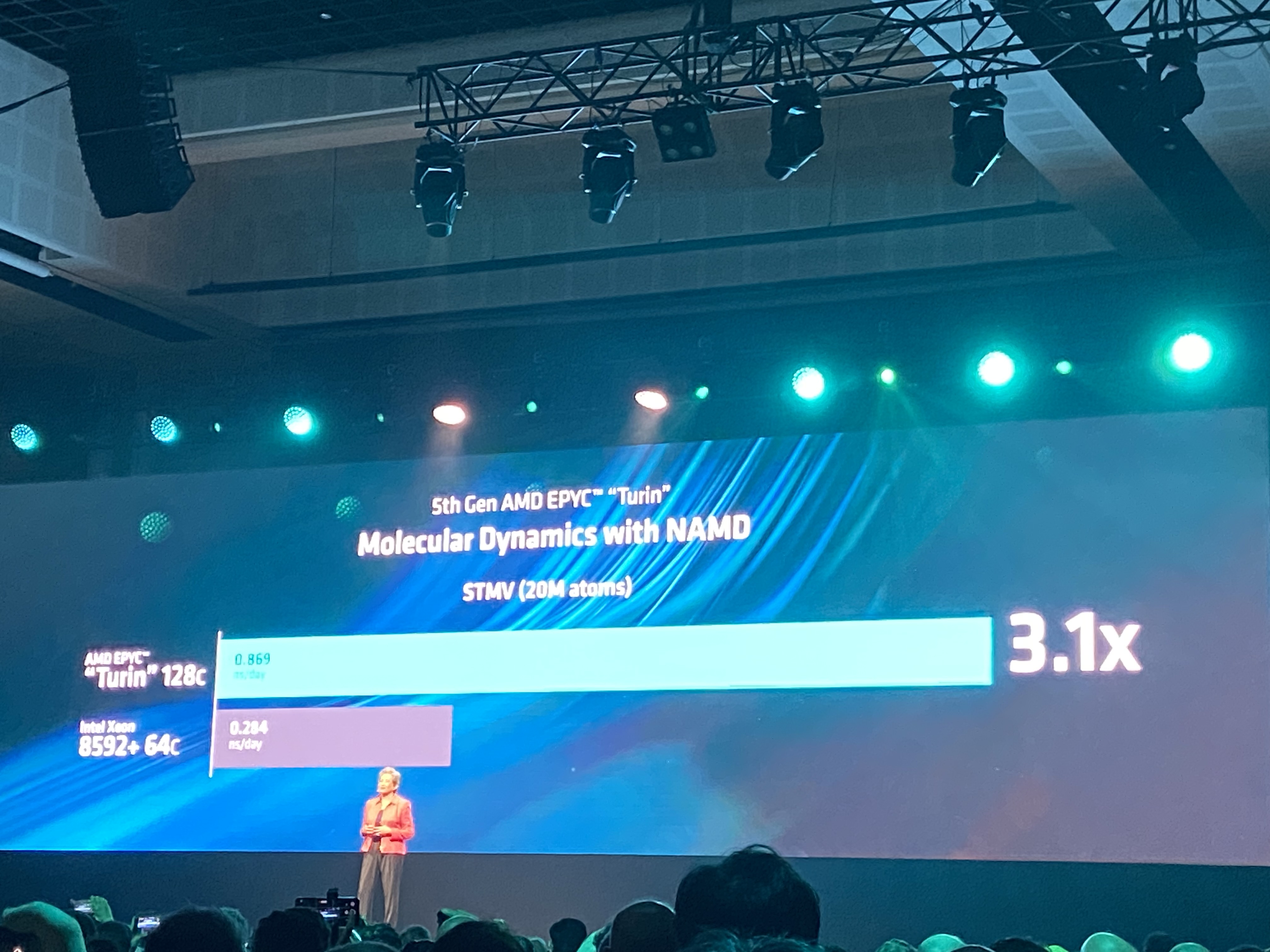

從傳統的IT應用程式,到小型企業的大型語言模型(LLM),再到大規模的AI應用程式,資料中心正在運行著許多不同的工作負載,而這些工作負載需要不同的運算引擎,對此,蘇姿丰也宣布代號為「Turin」的第5代AMD EPYC處理器將採用Zen 5核心架構,且多達192個Zen5核心以及384執行緒。若與Intel Xeon 8592+ 64核心相較,同樣模擬2千萬個原子,在NAMD(分子動力學軟體)中運行STMV基準的效能比較下,AMD 128核心EPYC Turin CPU速度是其3.1倍,這意謂著研究人員可以更快完成模型,從而在藥物研究方面取得突破。

相較Intel Xeon 8592+ 64核心,同樣模擬2千萬個原子,在NAMD(分子動力學軟體)中運行STMV基準的效能下,AMD 128核心EPYC Turin CPU速度是其3.1倍。

相較Intel Xeon 8592+ 64核心,同樣模擬2千萬個原子,在NAMD(分子動力學軟體)中運行STMV基準的效能下,AMD 128核心EPYC Turin CPU速度是其3.1倍。

在GPU方面,繼AMD Instinct MI300X之後,AMD將於今年第四季再推出AMD Instinct MI325X加速器,隨後則是AMD Instinct MI350系列,採用全新AMD CDNA打造,預計在2025年上市,其AI推論效能將比AMD CDNA 3架構的AMD Instinct MI300系列大幅提升35倍。

她提到,AMD Instinct MI300X加速器已受到諸多合作夥伴與企業的熱烈採納,在一部配備8個AMD Instinct MI300X加速器與ROCm 6軟體並運行Meta Llama-3 70B模型的伺服器,對比NVIDIA H100將可提升到1.3倍的推論效能以及token生成吞吐量。而AMD Instinct MI350系列採用AMD CDNA 4架構打造,並配備288GB的HBM3E記憶體,預計將比輝達B200產品多出0.5倍記憶體和20%的運算TFLOPS。

Intel發布Xeon 6處理器 結合Gaudi花更少得更多

英特爾(Intel)執行長Pat Gelsinge(基辛格)在「讓人工智慧無所不在(Bringing AI Everywhere)」的主題演講中則強調,「摩爾定律還活著,而且還活得很好。」他同時也點出Intel與台灣的好交情,自1985年英特爾來到台灣展開業務至明年將屆滿40週年,而這也意謂著與台灣交情已長達40年,基辛格妙喻,「IT」其實就是英特爾(Intel)加上台灣(Taiwan),希望與台灣的合作夥伴一同改變世界。

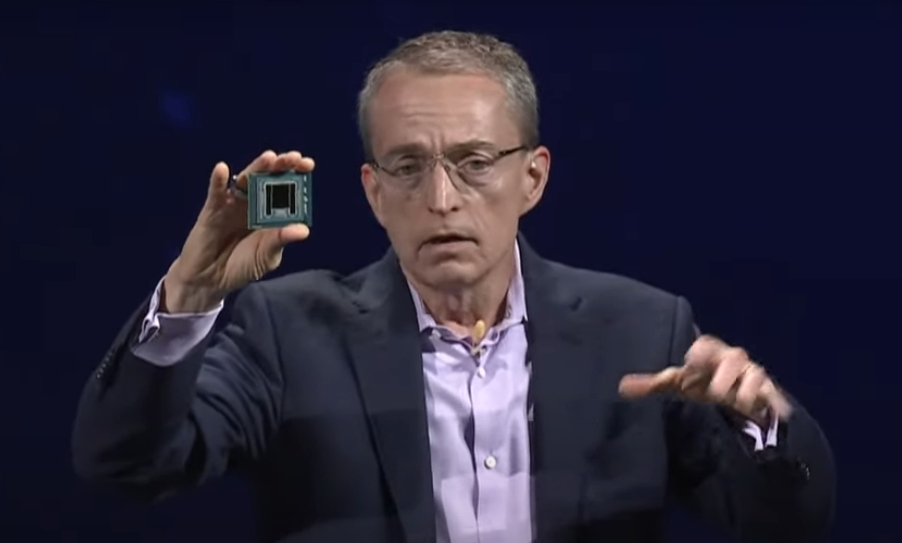

英特爾(Intel)執行長Pat Gelsinge發布Xeon 6處理器,這是首款採用Intel 3奈米製程的伺服器處理器。

英特爾(Intel)執行長Pat Gelsinge發布Xeon 6處理器,這是首款採用Intel 3奈米製程的伺服器處理器。

就像25年前進入網路時代,在AI時代,每個設備都將變成AI裝置,每家企業也將變成AI公司,人工智慧無所不在而且不斷擴展人們的體驗,對此,基辛格也在主題演講中,展示橫跨資料中心、雲端、網路、邊緣運算和PC等領域的多項領先技術和架構,包含Intel Xeon 6處理器、Lunar Lake、Intel Gaudi 2和Intel Gaudi 3 AI加速器套件的定價。

他提到,企業需要可擴展且靈活的基礎架構以及標準的平台與現有的系統整合來運行軟體,並且正確地處理資料,同時期待開放的生態系統以最大化選擇,當然也需要更多的運算以及效能,以取得更高密度與能源效率,還有更高的伺服器容量。對此,Intel發布Xeon 6處理器,這是首款採用Intel 3奈米製程的伺服器處理器,其內建效率核心(E-core),每個插槽最多144個核心,能為工作負載輸送量提供更強的平行處理能力,並且針對資料中心的高密度、規模化工作負載進行最佳化,大幅提升效能與能源效率。

對比同等規模的NVIDIA H100 GPU叢集,Gaudi 3的模型訓練可縮短40%模型訓練時間。

對比同等規模的NVIDIA H100 GPU叢集,Gaudi 3的模型訓練可縮短40%模型訓練時間。

與第2代Intel Xeon處理器在媒體轉碼工作負載上的表現相比,Intel Xeon 6處理器讓機櫃密度提升三倍,每瓦效能最高提升2.6倍,滿足資料中心對效能和能耗的嚴苛要求。基辛格也預告接下來還會推出288核心Xeon 6處理器。

隨著雲端發展日益成熟,已有超過60%的工作負載運行在雲端中,然而仍有超過80%的資料仍然存放在On-Premises環境,面對生成式AI的應用需求,不只需要Intel Xeon處理器,也需要專為AI工作負載設計的Intel Gaudi AI加速器來因應RAG等AI工作負載,他指出Intel Gaudi系列加速器不僅具備高效能,且總體成本低於其他平台的三分之一。此外,將Xeon處理器與Gaudi AI加速器整合於單一系統,可提供更快速、更實惠且更普及的AI解決方案。

他強調,Intel Gaudi架構作為唯一通過MLPerf基準測試的NVIDIA H100替代方案,而Gaudi 3能夠帶來更好的效能表現,對比同等規模的NVIDIA H100 GPU叢集,Gaudi 3的模型訓練可縮短40%模型訓練時間,在運行Llama-70B和Mistral-7B等大型語言模型(LLM)時,推理效能平均較NVIDIA H100提高2倍,更有助於企業「花得更少,得到更多。」

不只在資料中心端,AI也在PC端帶來全方位運算體驗,對此,英特爾推出新世代Lunar Lake客戶端處理器架構的系統單晶片(SoC),這款AI PC處理器,主要是由兩大晶片塊組成,一是運算晶片區塊,其包含最新一代E-core與P-core,兩者均導入全新的微架構,可實現前所未有的效率。運算晶片塊同時搭載全新Xe2 GPU繪圖架構、NPU 4與IPU(Image Processing Unit),可提供更強大的繪圖、AI運算與多媒體處理能力。另一則是平台控制晶片塊(Platform Controller Tile,PCT),其整合了安全性與連接性功能,透過內建安全引擎打造強大整合式安全解決方案,為系統保護奠定堅實基礎。

基辛格強調,預估到了2028年,將有80%的PC都將是AI PC,而英特爾已著手打造最佳化AI PC軟硬體平台。除了以Core Ultra平台為基礎外,也與100家以上獨立軟體供應商(ISV)緊密合作,共同打造300項AI加速功能和500種AI模型。「Lunar Lake NPU可提供高達48 TOPS的AI運算效能,較上一代的運算能力提升4倍,可最佳化生成式AI使用體驗。」