AI已成為新世代的頭號顯學,「探索AI」更是企業目前在積極了解其影響與衝擊,生成式AI也確實在慢慢地掀起產業巨浪,並在企業管理階層引發新意念。敦陽科技(2480.TW)在資訊服務領域超過30年經驗,擁有同為HPE的經銷夥伴與NVIDIA的專業認證Solution Provider,隨著AI飛速進展,AI伺服器趁勢崛起的年代,已經成功為製造、金融、政府、醫療、教育等眾多應用案場的客戶協助導入AI標的應用,快速且安穩地佈建AI平台。尤其隨著生成式AI爆紅,更讓AI應用觸角加速延伸到各種領域,以AI簡化價值實現時間。

HPE提供軟硬齊全的AI伺服器產品。

HPE提供軟硬齊全的AI伺服器產品。

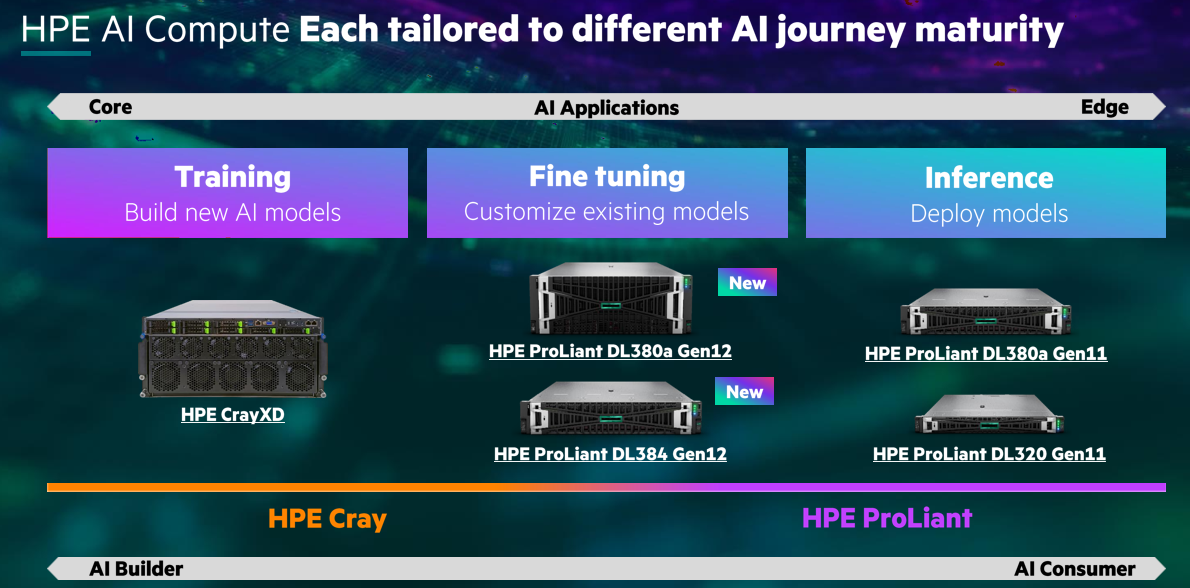

Hewlett Packard Enterprise(HPE)於2024 NVIDIA GTC大會上宣佈更新其在業界最完整的AI原生產品組合之一,以加速生成式人工智慧(GenAI)、深度學習和機器學習(ML)應用的運作。更新內容包括:

- 兩款由HPE與NVIDIA共同開發的GenAI全端解決方案。

- HPE機器學習推論軟體(Machine Learning Inference Software)的預覽版本。

- 企業級檢索增強生成(RAG, Retrieval-Augmented Generation)參考架構。

- 支援未來採用新NVIDIA Blackwell平台的產品開發。

HPE對於AI需求逐漸強大的市場,增加對NVIDIA最新GPU、CPU和超級晶片的支援。

- HPE Cray XD670 支援八個NVIDIA H200 NVL Tensor Core GPU,是大型語言模型建構者的理想選擇。

- 具備NVIDIA GH200 NVL2的HPE ProLiant DL384 Gen12伺服器非常適合使用較大模型或RAG的大型語言模型使用者。

- HPE ProLiant DL380a Gen12伺服器支援多達8個NVIDIA H200 NVL Tensor Core GPU,非常適合尋求靈活擴展 生成式AI工作負載的大型語言模型使用者。

- HPE將會及時支援NVIDIA GB200 NVL72/NVL2,以及新的NVIDIA Blackwell、NVIDIA Rubin和NVIDIA Vera架構。

運行大規模AI工作負載的企業組織需要更有效率的冷卻解決方案。直接液冷是冷卻次世代AI系統最有效的方式,而HPE正是該技術的先驅。憑藉這項關鍵冷卻技術,HPE的系統在Green500全球最節能超級電腦排行榜前十名中佔了七個席位。

HPE發表的架構僅採用液冷技術,比市面上其他替代方案更具能源與成本效益。事實上,相較於傳統氣冷系統,這套直接液冷架構可降低90%的冷卻功耗。HPE在部署全球最大規模液冷IT環境的專業技術,以及長達數十年的市場領導地位使HPE處於優勢位置,得以持續掌握AI市場需求。

此系統架構建基於四大支柱:

- 支援八大元件的冷卻設計,涵蓋GPU、CPU、完整的刀鋒伺服器、本地儲存裝置、網路架構、機架/機櫃、pod/叢集,以及冷卻液分配單元(coolant distribution unit,CDU)的液冷技術。

- 高密度與高效能的系統設計,並透過嚴格的測試、監控軟體和現場服務,確保這些複雜的運算與冷卻系統能順利部署。

- 整合式網路架構設計,適用於大規模整合低成本與低功耗的連接。

- 採用開放式系統架構,客戶能靈活選擇適合的加速器。

此款100%無風扇直接液冷架構具備獨特優勢,相較於混合式直接液冷,使用此架構能讓刀鋒伺服器所需的冷卻功耗減少37%,進而降低電力成本、碳排放量,及資料中心的風扇噪音。此外,其可支援更高的伺服器機櫃密度,使占地面積能減少一半。

獨家AI產品優惠,請洽HPE 經銷商 - 敦陽科技。

進一步了解 HPE 產品相關資訊需求,歡迎聯繫