近幾年來,IT技術有了長足的發展。例如使用高密度與高效能的伺服器(像是刀鋒伺服器)來統一替換過時的硬體設備,利用虛擬化技術來拓展和彈性化運算資源以滿足不斷變化的需求,以及雲端運算的興起等,種種的技術變革連帶也讓資料中心變得日益複雜。

資料中心的管理人員必須不停地自問:既有的電力和空調系統有能力再容納新的配置或技術嗎?新安裝的設備對於現有電力或空調系統會有那些影響?下一台伺服器該安裝在哪裡?該如何解決資料中心的熱點問題?資料中心的電力和空調什時候會不夠用?資料中心有符合相關節能法規的要求嗎?政策一直要求減少日常運行成本,又該怎麼做?

其實這些問題在今日已經有許多相關的技術可以解決,接下來將以案例說明資料中心如何利用空調設備與監控軟體來解決上述這些問題。

空調設備與技術的運用

空調設備向來是資料中心不可或缺的元素,它的存在就像伺服器一定要依賴風扇帶走熱氣般的自然。在資料中心中,冷卻系統有著至關重要的角色,即使世界最快的超級電腦也必須仰賴好的冷卻設計才能運作。2010年座落於天津中國國家超級電腦中心的「天河一號」號稱是目前世界最快的超級電腦中心,總共約有140個機櫃,每台機櫃用電最高可達56kw,而平日機櫃運作至少也有40kw。一般而言,單一機櫃用電20kw~30kw就算高密度機房,能到40kw已經相當驚人。聽到負載突破40kw,不禁令人第一個念頭就該想到冷卻怎麼辦?

從成本的角度來看,用有限的坪數,在固定的機櫃中放進最大量的伺服器以物盡其用,感覺上好像很合理,但明眼人都知道,這些伺服器散發出來的熱,恐怕不是一般資料中心可以承受,熱點將會是個嚴重的問題。因此,56kw產生的熱如果沒有好的冷卻系統,這些斥資六億人民幣(約逾26億台幣)製造的超級電腦今日應該是廢鐵一堆。那麼天河一號是如何解決這個問題?答案是善用機櫃式空調以及先進的水冷式設計。

|

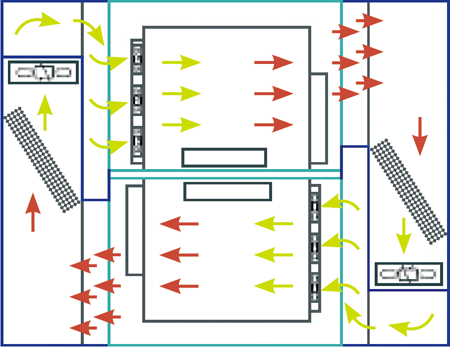

| ▲圖1 天河一號超級電腦中心的冷卻系統示意圖。 |

上圖是天河一號超級電腦中心的冷卻系統示意圖。從圖中可以明顯感覺到,天河一號不是以冷熱通道為主要設計,這座超級電腦中心氣流的方向是側向,前後密閉以進行完整的氣流循環,機櫃的擺設方向是一正一反,左右兩側各放一台冰水式機櫃式空調。

當右邊的冷空氣進入機櫃帶出熱空氣後,熱空氣被吸入空調機中再被收集到左邊的冷凝盤,進行冰水冷卻後,再將冷空氣吹出由另一台機櫃吸入,如此重複循環,以達到最佳的散熱效果。

天河一號的例子恰巧對高密度機房及熱點問題處理做了完整示範,這個例子雖然極端,但從技術的論點來看,要在有限的土地上擠進最大化的IT設備並非沒有可能,而且用電密度幾乎也達到高峰。

環境監控讓資料中心也能最佳化

不過,資料中心可不只有熱點問題而已。資料中心完成後,所有的IT設備都在最佳配置狀態中,然而隨著新專案的推出,資料中心開始變了樣,不斷地以空間為擺放基準的結果,很有可能造成不知道現有的電力設備夠不夠支應?資料中心空調不均,像冷熱的三溫暖。甚至企業導入虛擬化以及雲端相關技術後,資料中心更出現巨大的變化,也讓資料中心管理更為複雜。

也因此,環境監控軟體就順勢而生。主要目的是用來連接IT以及設施層,以達到資料中心最佳化的目的。這可達到三方面的效益,分別是經濟性(Economics)、可用性(Availability)以及管理性(Management)。像是確定和減少過度預防措施和冗餘、降低運營成本、發現潛在的問題、精確的測量方法和模擬,減少故障、配置和部署使可用性最大化以及更快速地回應業務的挑戰等等都是環境監控能帶來的優勢。

接下來以圖示說明,環境監控如何讓資料中心展現完全的透明與可視性。這次的示範圖示採用的是APC by Schneider Electric資料中心基礎設施管理(DCIM)軟體。

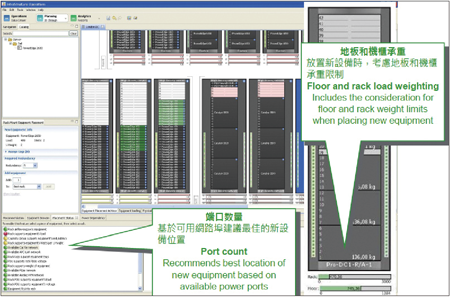

一般來說,無論企業的資料中心是什麼形狀、採用那些廠牌的設備、設備的型號以及重量通通都會被建立在GUI界面中,管理人員可以透過拖曳的方式來建立並模擬真實的資料中心,也包括機櫃、電力、冷卻設施。

圖2是詳細的機櫃佈局。在這個圖中可以看到,考量新設備的放置地點時,也要考量地板能不能承受重量,過去在印度就曾發生一個案例是機櫃因為太重而導致高架地板彎折的狀況,這其實是很危險的事情。

|

| ▲圖2 詳細機櫃佈局。 |

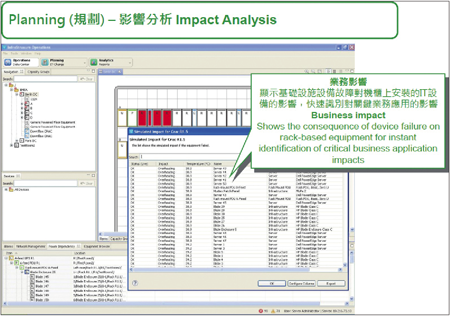

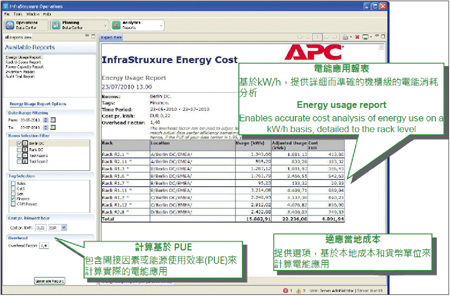

圖3展示的是萬一空調設備發生故障可以立即分析得知目前對企業會造成那些影響。而這些種種的模擬,最終為的就是如圖4般得知相關成本,並且降低支出。

|

| ▲圖3 影響分析。 |

|

| ▲圖4 電能應用成本。 |

隨著IT基礎架構不斷變化,資料中心也應該即時地調整空調、電力等總體營運環境,要達到這個幾近完美的資料中心,環境設施與監控軟體都扮演著重要的角色,該如何彈性地運用這些工具,將資料中心效益最大化也考驗著企業的智慧。