企業日漸加深仰賴AI和ML系統做出關鍵決策,為確保這些系統在創建資料集到ML模型部署的過程中維持安全和可信任,英特爾提出一個結合詮釋資料、以硬體為基礎的防護機制和透明日誌的多層框架,可在模型生命週期內追蹤及加強ML模型的安全性。

負責任的AI是確保機器學習(Machine Learning,ML)系統的完整性與透明度,使模型譜系(Model Lineage)的能力成為道德機器學習開發的重要基礎。

隨著企業組織日漸加深仰賴人工智慧和機器學習系統做出關鍵決策,開始導入各種方法強化ML推論系統的隱私性和透明度,確保這些系統在創建資料集到ML模型部署的過程中維持安全和可信任相當重要。

對此,英特爾提出一個結合詮釋資料(Metadata)、以硬體為基礎的防護機制和透明日誌的多層框架,可在模型生命週期內追蹤及加強ML模型的安全性。目標是透過實施這些安全措施,使組織能夠防範新興威脅、建立與利害關係人之間的信任、符合法規要求,並在AI領域保持競爭優勢。

AI系統容易受到供應鏈攻擊和所謂「資料汙染(Data Poisoning)」的影響,惡意行為者可以操縱用於訓練AI模型的資料,以創造後門或漏洞。舉例來說,訓練一個AI系統來識別照片中的貓,但有人悄悄地修改了訓練資料,並加入隱藏的觸發器,讓AI在圖片出現特定圖案時,將狗誤認成貓。

現實生活中的資料汙染攻擊案例突顯其風險,例如研究人員發現,僅對熱門訓練資料集進行0.01%的目標修改就足以誤導ML模型,使其對圖片進行錯誤的分類。

另一個案例是X推出聊天機器人,卻在上線的幾小時內就開始發表冒犯性言論,是因為它遭到不良使用者的惡意推文轟炸。

ML流程基礎與核心挑戰

ML流水線(Pipeline)涉及眾多組織和參與者在ML模型開發的不同階段進行協作,從安全性角度而言,每個參與者之間的轉換都可能造成潛在的安全漏洞。在任何訓練開始之前,資料科學家會先蒐集和準備訓練資料,ML供應商則會花費大量時間開發ML演算法、修改資料集和微調參數。接著,工程師會建構並維護訓練基礎架構,外部承包商則可能負責專門的模型微調,而營運團隊管理模型部署以進行推論。

AI模型開發的投資成本相當可觀,無論是在運算資源還是專家方面;這個「準備階段」至關重要,需要享有與「訓練過程」本身同等的保護。

當資料從蒐集階段轉移至預處理階段時,該如何驗證資料沒有發生未經授權的修改?當外部承包商微調模型時,該如何確保他們精確地遵循指定程序?

英特爾實驗室亦針對ML模型生命週期中的兩個關鍵威脅進行重點研究,分別是資料汙染攻擊和模型供應鏈風險,其中包括程序遭到破壞以及預訓練模型中的潛在後門。

這兩種威脅皆突顯了ML系統中穩固的安全措施和來源追蹤的重要性。開放全球應用程式安全計畫(Open Worldwide Application Security Project,簡稱OWASP)也將資料汙染與供應鏈漏洞列為開發和保護生成式AI與大型語言模型(LLM)應用的十大風險、漏洞和緩解措施榜單中。

資料汙染和模型篡改

當訓練AI模型時,會向模型提供大量資料進行學習,資料汙染是指有人故意破壞訓練資料,使模型在特定情況下表現不正確。攻擊者可能會對圖片進行細微修改以造成錯誤分類、插入惡意範例造成隱藏後門,或是導入有偏見的資料扭曲模型決策。這些攻擊通常很難透過傳統方法檢測,因此可能特別危險。

委外訓練與預訓練模型的風險

許多組織將其ML模型訓練委託給外部承包商,或是下載由第三方開源社群平台(如Hugging Face)預訓練的模型,以節省時間、精力和成本。

然而,這些情況會出現重大的安全性疑慮,因為要理解模型的供應鏈變得更加困難:它們是否會如同宣傳中所言般進行訓練?它們是否包含隱藏的安全漏洞?

舉例來說,在ML流程中使用弱網(Weak Network)或資料加密,會讓攻擊者更容易竊取敏感的訓練或模型資料。未遵循適當的訓練程序或在訓練過程中偷工減料,例如減少訓練迭代次數,可能會損害模型的準確性和可靠性。

這些問題突顯了使用外部來源的ML模型時,模型來源、完整性驗證和全面安全性審核的重要性。為了解決這項關鍵問題,英特爾實驗室提出一些方法,以檢查模型成分和流程運作是否符合我們對完整性和安全性的期待。

建構安全基礎:英特爾的三層防護機制

提升ML流程可信度所面臨的根本挑戰,在於追蹤和驗證該高度複雜流程內每個階段的完整性,前提是可以驗證提供資料或模型成分的組織和參與者身分。英特爾的驗證流程在多個層級上克服了這項挑戰:

資料層級完整性

‧追蹤每筆不同資料來源的分支以及演算法選擇。

‧測量雜湊值(Hash)並以數位簽章簽署每個工件(Artifact),例如資料、預處理腳本、MLOps工具、轉換程式碼等。

即時驗證 ‧在作業之前,持續驗證先前生命週期階段的輸入和詮釋資料是否符合預期。

‧追蹤ML模型成分轉換和運算環境軌跡。

‧為每次轉換產生經驗證且具數位簽章的詮釋資料,其中包括來源資訊。

模型譜系

‧記錄不同ML模型成分之間的互連和依賴關係。

‧透過連結的營運詮釋資料,從資料準備到模型部署,建立可驗證的證據鏈。

實務上的驗證挑戰

不過,將這些三層防護機制應用於整體流程時,可能會遇到一些實務挑戰,包含信任建立、效能影響、部分更新以及營運的複雜度:

信任建立

為了追蹤並驗證處理委外作業,如資料準備、認證或模型訓練等眾多第三方組織和參與者的可信任度,需要穩固的憑證管理和持續監控。

效能影響

持續的測量和驗證,將為每個流程階段增加額外負擔,組織必須謹慎衡量安全性與效能需求。在檢查簽章和運算完整性測量時,所需的運算資源可能會影響訓練速度。

部分更新

在實務上,組織往往需要針對個別成分或階段進行修改,而不是重建整個流程。當流程僅需部分調整時,如何確保其完整性將成為挑戰,解決方案涉及了謹慎設計的驗證架構,以支援漸進式更新,同時維持安全性保證。

營運複雜性

流水線運算(Pipeline Operators)需要明確的完整性狀態指示,以及處理驗證失敗的簡要流程。當簽名檢查失敗或完整性測量與期待值不符,系統必須提供可執行的資訊,以協助運算子理解、追蹤並解決問題。

深入探討技術:英特爾如何確保ML模型生命週期值得信任

英特爾提出之方法的核心在於策略性結合軟硬體技術,讓使用者能夠記錄資料完整性、追蹤模型譜系,並執行即時驗證。

接下來,將深入地探討其中幾項技術,展示它們如何為ML模型生命週期帶來端對端的信任。

機密運算和安全基礎

機密運算是用來強化ML流水線完整性的基礎技術。這項技術透過以硬體為基礎的安全功能,建立獨立且經驗證的運算環境,也就是所謂的硬體隔離區(Hardware Enclaves)。

像是Intel Software Guard Extensions(Intel SGX)和Intel Trust Domain Extensions(Intel TDX)等解決方案就能打造可信任的執行環境,以硬體支援的保證來執行完整性測量。這些系統使用一種獨特的數位指紋資料創建方法,也就是「加密雜湊」(Cryptographic Hashing),生成完整性測量並驗證模型成分是否被惡意行為者篡改。

當模型訓練流程啟動時,利用機密運算可達成:測量並證明訓練程式碼的真實性和完整性、驗證輸入資料未被修改、確保配置參數保持不變、使用硬體保護的密鑰簽署測量結果,以及將結果記錄於透明日誌系統中。

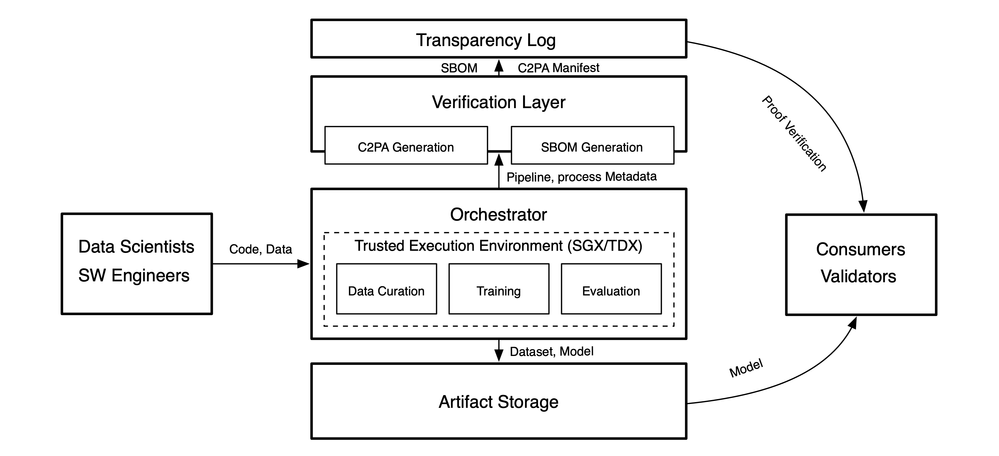

英特爾ML流水線完整性框架的高階架構。

英特爾ML流水線完整性框架的高階架構。

追蹤ML模型譜系:全面驗證的方法

想像模型譜系就像一份家庭族譜,每個分支代表不同的資料來源、演算法選擇或訓練參數。檢視一個完成的模型時,需要追溯其歷史,以了解完整脈絡。其中也包括驗證:

‧訓練資料的來源和轉換

‧�模型開發期間所做的特定演算法選擇

‧訓練參數的選擇

舉例而言,可以想像一個自然語言處理模型,其訓練資料來自多個源頭,部分訓練資料可能來自社群媒體,另一部分則來自正式文件。每個資料來源都經過不同的預處理步驟,例如社群媒體文本需要針對表情符號和縮寫進行特殊處理,而正式文件則需保留其原有結構。英特爾提出的驗證框架,使用了現有的軟體供應鏈完整性方法,能分別追蹤這些來源,同時確保它們之間的關聯性。

確保驗證鏈安全

英特爾實驗室的驗證過程採用遞迴(Recursive)方式,在驗證任何資料或軟體成分時,系統會自動驗證所有依賴項(Dependencies)。簽署的過程中,資料及其詮釋資料周圍會建立一個預防篡改的密封,如果有人試圖修改資料或其關聯的詮釋資料,簽章將失效,並會立即被標示為潛在篡改行為。

研究顯示,將驗證從後處理階段改於ML模型的生命週期中進行即時且持續的驗證,可以幫助及早發現潛在問題,避免問題在整個流程中擴散。

早期概念驗證實施

初始的概念驗證工作,展示了全面的ML模型生命週期安全性的實際可行性。為了實行此框架,整合了內容來源與真實性聯盟(Coalition for Content Provenance and Authenticity,C2PA)的詮釋資料管理標準;基於Sigstore Rekor的透明日誌,其用於維護模型預處理和訓練操作的不可變記錄,以及提供以硬體為基礎之安全保證的Intel TDX。

持續驗證和透明度日誌會讓惡意行為者更難導入中毒資料,因為任何未經授權的修改都會立即被系統標記。此外,概念驗證還包括可以進行端對端流程驗證的工具。

實作的效能分析表現優異,延遲成本(latency Overheads)介於6~8%之間,主要來自詮釋資料生成與驗證、簽署的加密運算、透明度日誌更新與驗證,以及以硬體為基礎的證明流程,這些成本會因特定訓練情境和資料集特性而有所差異。

面向未來的可信任ML流水線

端對端ML模型生命週期的安全性涉及多重挑戰,從測量、驗證到信任關係都得小心注意。建構安全的ML模型取決於技術解決方案的結合,像是以硬體為基礎的安全機制、加密技術和完整的軟體供應鏈,同時也須兼顧可用性和效能等考量。隨著該領域持續發展,投資ML流程安全性的組織,將能更妥善地部署值得信賴且負責任的AI系統。

<本文作者:王宗業英特爾客戶端邊緣運算事業群平台研發協理。負責Intel Edge AI平台生態系統的推廣,帶領過智慧零售、智慧製造、智慧交通與智慧醫療等專案的開發。在20多年的軟硬體開發、推廣、客戶支援經驗中,含括嵌入式系統、智慧型手機、物聯網、Linux及開源軟體、AI硬體加速器在影像與自然語言處理等領域,並擔任過台灣人工智慧學校經理人班、技術領袖班與Edge AI專班的講師,以及大專院校的深度學習課程業師。>