為協助AI資料中心因應能源挑戰,產業界積極推動各種創新半導體與IT技術方案,包括更低功耗的處理器、更高能效的電源晶片與功率元件、浸沒式冷卻(Immersion Cooling)技術、智慧化能源管理系統,或藉由軟體虛擬化技術,期能全面提升資料中心能源使用效率和減少熱與溫室氣體排放。

打造永續資料中心 聚焦五大重點

Uptime Institute北亞區董事總經理胡嘉慶(圖1)認為,在ESG的風潮下,資料中心對環境帶來的衝擊,受到比過往更大的關注。要實現一座高永續性的資料中心,有許多複雜的環節需要注意,但整體來說可以分成五大重點:

圖1 Uptime Institute北亞區董事總經理胡嘉慶表示,打造永續資料中心的第一步,在於提高IT設備的使用效率

圖1 Uptime Institute北亞區董事總經理胡嘉慶表示,打造永續資料中心的第一步,在於提高IT設備的使用效率

‧IT效率:IT設備每兆瓦時(MWh)耗電所提供的運算效能必須最大化

‧降低能源的碳足跡:每MWh能源的碳排量極小化

‧用水量:盡量減少或消除冷卻用水

‧物料管理:降低採購設備和物料的碳含量

‧供應商管理:要求供應商制定和執行永續戰略

不過,考量到客觀條件,對資料中心的擁有者而言,不是每一項都能操之在己。例如全面導入無碳能源,現階段就很難做到。比較可行的目標設定是例如在2035年或2040年時,無碳能源占整體能源使用量的80%~90%。

可操之在己的部分,則是提升IT效率與降低用水量。提升IT效率的最有效方法,是提高IT設備的使用率(Utilization),並盡可能經常更新IT設備。前者不難理解,IT設備使用率沒有最佳化的資料中心,一定會浪費不少能源;經常更新IT設備則是因為新一代運算設備往往具有更好的每瓦功耗/效能比。至於降低用水量,則必須透過資料中心改建或淘汰舊的資料中心來實現。

提高生成式AI能效 Arm軟硬齊發

安謀(Arm)首席應用工程師張維良(圖2)指出,在生成式AI無處不在的今天,要實現更永續的運算,必須導入次世代的伺服器解決方案。以能源效率聞名於業界的安謀,不只能提供CPU核心,更在軟體布局上投入大量資源,以便讓業界能更容易導入基於安謀架構的高效能運算平台。 張維良認為,提到生成式AI,一般都會聯想到GPU或TPU這類專門用來訓練AI模型的加速器,但其實80~85%的AI工作負載是用在推論,而不是訓練。因此,提高推論任務的每瓦效能,才是提高生成式AI能源效率的關鍵。

圖2 安謀首席應用工程師張維良指出,為了讓業界更容易導入安謀架構,打造更高能效的生成式AI伺服器,該公司將採取軟硬體齊頭並進的策略

圖2 安謀首席應用工程師張維良指出,為了讓業界更容易導入安謀架構,打造更高能效的生成式AI伺服器,該公司將採取軟硬體齊頭並進的策略

要實現這個目標,選擇正確的模型非常重要。經過微調,專門針對特定任務最佳化的中、小型模型,不僅可以節省運算量,同時也能有不輸給大模型的效能表現。選擇正確的模型後,接下來就是導入更有效率的硬體。如果只處理推論任務,經過特化的CPU,其實也能扮演一定的角色,例如安謀推出的Neoverse,就有許多專門針對AI運算所設計的功能區塊。

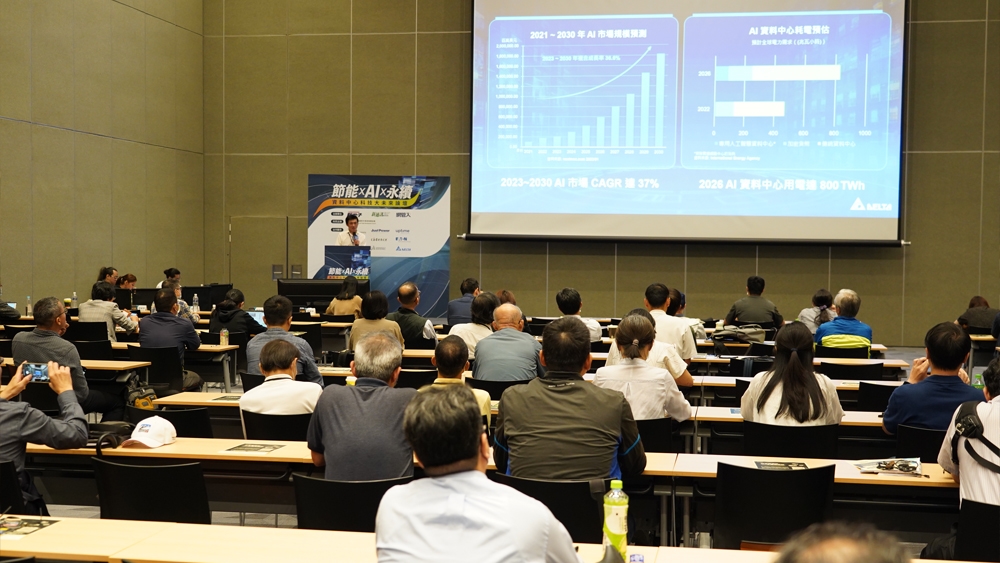

台灣國際智慧能源週期間,許多學員參與「節能×AI×永續資料中心科技大未來論壇」

台灣國際智慧能源週期間,許多學員參與「節能×AI×永續資料中心科技大未來論壇」

不過,安謀也深知,要讓業界從x86架構轉向安謀架構,軟體生態系的健全度至關重要。因此,安謀除了持續開發新的處理器跟加速器矽智財(IP)之外,同時也在AI/ML軟體堆疊、開發工具等生態系建構方面,投入大量資源。例如Kleidi AI加速框架,可以支援大多數AI框架與函式庫,就是安謀為加強AI生態系建構所提出的方案之一。在Kleidi打造的基礎上,許多安謀生態系的夥伴,都已經開發出更高效能、同時也更低成本的AI應用。

資料中心設計須高度整合

AI資料中心的快速發展是一把雙面刃,其高算力實現大量新興應用,但也需要耗費大量的電能與水資源。益華(Cadence)應用工程資深經理王暉雄(圖3)指出,傳統的資料中心大多耗電8~10kW,AI資料中心如NVIDIA的Blackwell則耗電120kW,增加12倍以上,可見AI運算的耗電量驚人。此外,AI資料中心的散熱用水量也很大,例如Google的資料中心平均每天需要100~500萬加侖,大約相當於一個五萬人小鎮一天的用水量。AI資料中心龐大的耗電與用水量對環境造成衝擊,因此設計上需要朝向提高電力使用效率(PUE)值,也需要克服散熱挑戰。

圖3 益華(Cadence)應用工程資深經理王暉雄認為,數位分身能夠模擬資料中心設計與營運的情況,協助營運人員分析資料中心的散熱碳排數據

圖3 益華(Cadence)應用工程資深經理王暉雄認為,數位分身能夠模擬資料中心設計與營運的情況,協助營運人員分析資料中心的散熱碳排數據

資料中心的設計不離「整合性」的概念,包含垂直整合與水平整合。王暉雄說明,設計工具針對不同規模的裝置,從奈米等級的晶片工具,到資料中心的設計工具,都是獨立的系統。透過工具之間的垂直整合,設計人員可以分析從晶片端、系統端到資料中心端整體的運作狀況,並從中找到需要改善的部分。

在資料中心的設計流程中,不同工具之間需要轉檔,才能交換資料。甚至同一個產品可能採用來自不同供應商的工具,導致產品設計的不同階段難以整合。若是設計人員採用支援水平整合的設計工具,則有助於整體設計的優化。例如資料中心的散熱設計,就需要考量資料中心所有設計環節的資料,才能有效強化散熱效率。

例如Cadence的數位分身(Digital Twin)平台,能夠模擬資料中心設計與營運的情況,協助設計與營運人員分析資料中心的散熱碳排等數據。該平台除了整合資料中心的設計數據,也提供資料中心架構的函式庫,可以結合資料中心實際運作的量測數據建立AI模型,用來預測並分析資料中心的營運效率與耗能。該平台也能協助設計人員導入液冷等新系統時,事先進行模擬。

用電分析助資料中心節能

能源消耗越來越快,是AI資料中心等高耗能產業共同面對的課題,必須從數據收集、分析到管理,著手找出改善方向。伊頓飛瑞慕品(Eaton)企業業務經理黃哲宇(圖4)提及,面對資料中心等應用耗能持續增加,伊頓在工廠中導入智慧電表,並透過三到五年的用電量追蹤,協助高耗能產業執行能源的預估優化。長期的用電數據追蹤,有助於分析人員釐清該工廠的用電習慣,並從中找到可以改善能源消耗的方法。同時,透過AI分析用電數據,也能優化供應鏈管理。當供應鏈的營運效率增加,也能提高能源使用效率。

圖4 伊頓飛瑞慕品(Eaton)企業業務經理黃哲宇說明,長期的用電數據追蹤,有助於分析人員找到可以改善能源消耗的方法

圖4 伊頓飛瑞慕品(Eaton)企業業務經理黃哲宇說明,長期的用電數據追蹤,有助於分析人員找到可以改善能源消耗的方法

黃哲宇進一步表示,未來三年內,資料中心等高耗能產業需要從電力韌性、強化資料安全、升級模組化解決方案、持續投資前瞻技術,以及執行滾動式規畫五大面向,為未來趨勢做足準備。資料中心需要搭配強大的不斷電系統(UPS),或是結合儲能系統、太陽能發電系統等,避免天候變化等因素帶來的風險。同時,資料中心的營運者也需要隨時評估並修正設施的電力韌性需求,確保能源系統配置達到效益最大化。其次,資料中心需要建立完善的資安規範,確保資料傳輸的安全。

第三點是模組化升級的解決方案。由於資料中心等高耗能產業對能源的需求量持續增加,若是採取模組化的解決方案,將有機會實現在相同體積的產品中,提高能量密度與效能,持續滿足高耗能設施的需求。最後,持續投資前瞻技術與滾動式的規畫方向,有助於高耗能產業未來導入更多AI等技術,用以優化設施的效能與耗能。

冷卻系統攸關資料中心安全/效能

在高效能運算發展飛快之際,散熱成為AI資料中心難解的課題。柏斯托(Perstorp)潤滑油業務發展總監曾偉銓(圖5)認為,全球企業積極投資與建立資料中心,為環境帶來負擔,也增加大量的電力需求。根據國際能源署(IEA)統計,2021年資料中心用電占全球用電的1.5~2%,並預估2030年可能達到8%。同時,預計2040年資料中心造成的碳排,將會占全球碳排的14%。因此,從用電與環境永續的角度切入,提高資料中心與各項AI運算設備的能源使用效率勢在必行。

圖5 柏斯托(Perstorp)潤滑油業務發展總監曾偉銓提及,減輕資料中心電力負荷的做法之一,是透過提高散熱效率,來降低散熱系統本身的耗能

圖5 柏斯托(Perstorp)潤滑油業務發展總監曾偉銓提及,減輕資料中心電力負荷的做法之一,是透過提高散熱效率,來降低散熱系統本身的耗能

減輕資料中心電力負荷的做法之一,是透過提高散熱效率,來降低散熱系統本身的耗能。傳統的資料中心以氣體冷卻為主,目前部分AI資料中心開始導入浸沒式的液體冷卻系統,期望增加散熱效率並減少耗電。而冷卻液則是開發資料中心液冷系統的重要關鍵考量。曾偉銓解釋,冷卻液的重點是散熱效果,必須確保冷卻液能夠有效散熱。除此之外,冷卻液材料的選用,要全面考慮冷卻系統與所有資料中心中的設備材料特性,確保冷卻液的可靠性以及較長的壽命。在訊號傳輸方面,資料中心的系統部分接觸空氣,另一部分浸泡在冷卻液中,需要確認冷卻液不會導致傳輸訊號損失。

學員專注聆聽講師分享資料中心能源趨勢

學員專注聆聽講師分享資料中心能源趨勢

另外,冷卻液也影響到資料中心的安全性。冷卻系統供應商需要確認冷卻液的絕緣性等電性安全,避免火災情況時延燒,並且不能使用有毒性的化學成分。冷卻液的成分選擇,除了安全性,也要將冷卻液的回收成本納入考量,避免後續產生額外的處理成本。

電力緩衝/高壓控制不可少

因為大量耗能,AI資料中心的電力設計要求遠比傳統資料中心嚴苛。台達電電腦及網通事業部資料中心產品經理彭德智(圖6)指出,現階段雲端服務供應商大量投資AI資料中心,雖然目前AI伺服器占整體伺服器市場小於4%,但是預期2026年將成長到15%。Next Move Strategy Consulting預估2023~2030年AI市場的CAGR將達到37%。IEA則認為2026年AI資料中心的用電,將成長至800TWh。顯見全球資料中心面對AI應用的快速興起,將面臨嚴重的缺電問題。

圖6 台達電電腦及網通事業部資料中心產品經理彭德智觀察,世界各地的資料中心由於耗電量驚人,建立資料中心的地點逐漸往東南亞與中東擴散

圖6 台達電電腦及網通事業部資料中心產品經理彭德智觀察,世界各地的資料中心由於耗電量驚人,建立資料中心的地點逐漸往東南亞與中東擴散

現在一顆GPU需要耗電大約1,000W,超過一台傳統伺服器的功耗。短期內,AI資料中心單一機櫃的耗能大約為120~130kW,未來可能增加到500kW。為了解決AI資料中心的缺電與散熱問題,產業需要從電網、晶片與AI電源解決方案多管齊下,共同減緩資料中心的耗能衝擊。例如電網到晶片(Grid-to-Chip)方案便是涵蓋了從高壓交流電到低壓直流電的多層次轉換,以高效率的電壓轉換技術來滿足資料中心高功率、高密度的電力需求,有效降低功率耗損,顯著提升能效。

AI資料中心在龐大的電能需求下,也需要穩定的電壓控制。彭德智認為次世代的AI資料中心電力系統,需要在有限的尺寸與現有的材料中,盡可能提高電壓。因此他建議AI資料中心使用高壓直流供電(HVDC)技術,將800V的直流電從±400V高壓直流降壓為50V,再轉換到適用於AI伺服器和GPU的0.8V低壓電源。此外,搭配由功率電子元件堆疊而成的固態變壓器(SST),相較傳統變壓器使用鐵芯或銅圈,SST的體積較小,更能精確靈活控制電壓。

數位分身助散熱系統優化

AI資料中心從選址到硬體設計,都需要多重的分析與模擬,才能確保資料中心順利運作。達梭系統SIMULIA技術顧問葉育魁(圖7)觀察,AI伺服器在2010~2020年的十年間,工作負載大幅增加,資料中心的工作負載更增加六倍以上。世界各地的資料中心由於耗電量驚人,建立資料中心的地點從歐美、東亞,逐漸往東南亞與中東擴散。AI資料中心在新環境建廠,需要考慮模擬溫差、雷擊與地震等環境因素,作為散熱設計、訊號傳輸與其他設備設計的參考,例如雷擊可能干擾訊號。

圖7 達梭系統SIMULIA技術顧問葉育魁表示,AI資料中心在龐大的電能需求下,也需要穩定的電壓控制

圖7 達梭系統SIMULIA技術顧問葉育魁表示,AI資料中心在龐大的電能需求下,也需要穩定的電壓控制

除了考量AI資料中心建廠的環境因素,散熱模擬也至關重要。在東南亞與中東新建的資料中心,在規畫與設計初期會先分析該場域的氣流管線與空氣流動,取得初步的物理參數。這些物理參數可以建立小型的AI模型,由模擬軟體在其中建立更多的數位分身細節,包含使用哪些晶片與散熱鰭片、風扇位置的設計等。

講師分享多元的電源管理與資料中心散熱設計等經驗

講師分享多元的電源管理與資料中心散熱設計等經驗

數位分身的模擬可以針對每一個機櫃建立單獨的區塊,並輸入/輸出特定的溫度,再執行該機櫃在不同溫度下的熱流分析。每個機櫃的熱流分析結果,可以在模擬系統上輸出,導入到資料中心層級,並進行整體資料中心的熱流分析。

AI資料中心的數位分身除了分析數據,也要連接(Connect)、預測與優化數據。模擬平台透過可視化工具顯示每台伺服器的熱流,並預測整體的熱流與散熱系統的負載。取得預測數據後,設計人員就能持續優化資料中心的配置,盡可能降低耗能,並提高散熱效率。優化資料中心配置的方法之一,是由感測器監測進風溫度。如果某幾台伺服器的進風溫度上升,系統就自動將較多的工作負載分配給進風溫度較低的伺服器,藉此透過不同伺服器的搭配來調整整體的溫度,達到在資料中心維持相同算力的前提下,降低系統的耗能。