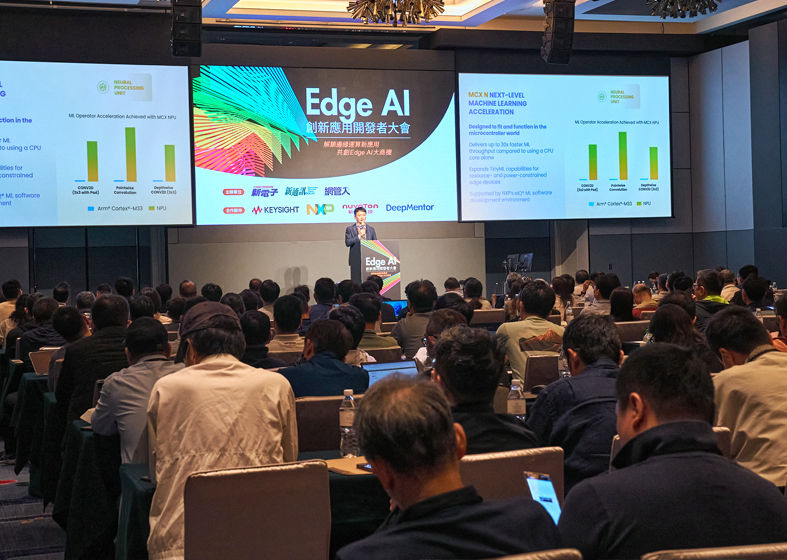

生成式人工智慧(AI)啟動新一波的AI應用熱潮,而邊緣AI高度安全、低延遲等優勢,也帶動大型語言模型(LLM)在終端裝置中的應用。將LLM導入邊緣端,需要足夠的記憶體容量,確保AI模型順利執行。將SSD用於AI運算,以及In-Memory Compute的技術進展,都讓邊緣端的算力更上層樓。而CXL協定確保裝置的資料傳輸順暢,SPOT技術則實現終端裝置常見的超低功耗需求。

CPO/LPO高速傳輸障礙

迎刃解

智慧裝置邊緣運算MCU

應用爆發

終端AI模型朝低算力/

高精度邁進